Gestensteuerung funktioniert jetzt auch bei Extrembedingungen

Neues KI-Wearable filtert Bewegungschaos heraus: Gesten steuern Roboter selbst beim Laufen, unter Vibration und im simulierten Wellengang.

Die neue Wearable-Technologie nutzt alltägliche Gesten, um Robotergeräte auch bei starken Bewegungsgeräuschen zuverlässig zu steuern, beispielsweise wenn der Benutzer läuft, in einem Fahrzeug fährt oder sich in einer turbulenten Umgebung befindet.

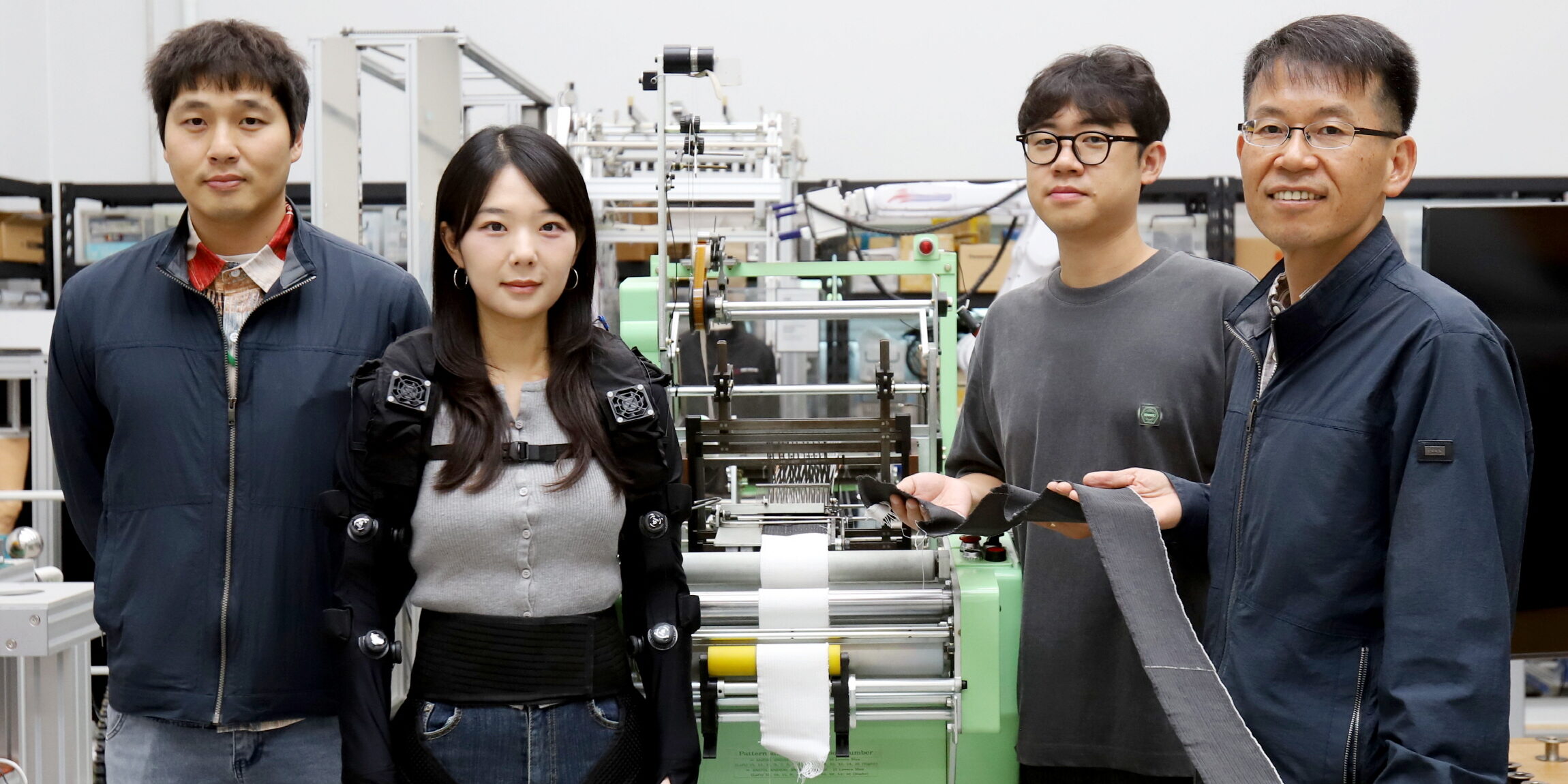

Foto: David Baillot/UC San Diego Jacobs School of Engineering

Ein Forschungsteam der University of California San Diego hat ein Wearable entwickelt, das Gestensteuerung selbst dann zuverlässig erkennt, wenn der Körper stark in Bewegung ist – etwa beim Laufen, unter Vibration oder in simuliertem Wellengang. Möglich wird das durch eine Kombination aus dehnbarer Sensorik, Elektromyografie und einem Deep-Learning-Modell, das Bewegungsstörungen gezielt herausrechnet und Roboter in Echtzeit steuern kann.

Co-Erstautor Xiangjun Chen erläutert die Heraussforderung: „Wearable-Technologien mit Gestensensoren funktionieren gut, wenn der Benutzer still sitzt, aber die Signale beginnen bei übermäßigen Bewegungsgeräuschen zu zerfallen“, erklärt er. „Unser System überwindet diese Einschränkung.“

Inhaltsverzeichnis

Warum klassische Gesten-Wearables im Alltag versagen

Technisch ist das Problem klar: Gestensensoren erfassen Beschleunigungen und Drehbewegungen des Arms. In der Praxis überlagern sich aber mehrere Effekte:

- die eigentliche Geste

- die Gesamtbewegung des Körpers (Laufen, Sitzen im Auto, Schwingungen)

- Lageänderungen im Schwerefeld

- zufällige Stöße und Vibrationen

Diese Störungen – in der Fachsprache „Motion Artefacts“ – haben oft ähnliche Frequenzen und Amplituden wie die Geste selbst. Ein einfacher Filter kann sie deshalb kaum sauber trennen. Viele Systeme werden so eingestellt, dass sie nur bei ruhigen Bedingungen sauber erkennen – und sind damit für den Alltag nur eingeschränkt geeignet.

Bisherige Lösungen setzen entweder auf Hardware-Tricks (dünnere Sensoren, bessere Haftung, zusätzliche IMUs an anderen Körperstellen) oder auf rechenintensive Signalverarbeitung. Beides hat Grenzen: Entweder wird es unflexibel oder zu langsam – vor allem, wenn viele Gesten in Echtzeit unterschieden werden sollen.

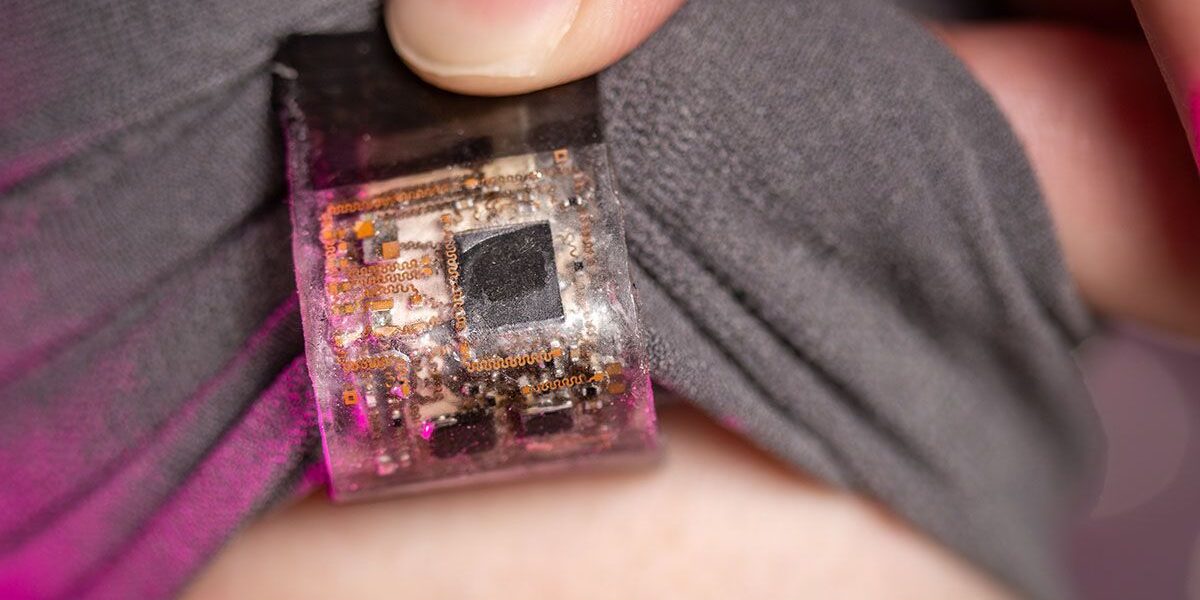

Ein weiches Elektronikpflaster als Schaltzentrale

Das Team um Sheng Xu und Joseph Wang wählte einen anderen Weg. Die Schnittstelle steckt in einem weichen Elektronikpflaster, das auf ein Stoffarmband am Unterarm geklebt wird. Darin integriert:

- eine sechskanalige Inertialmesseinheit (IMU) mit 3-Achs-Beschleunigungssensor und 3-Achs-Gyroskop,

- ein Elektromyografie-Modul (EMG), das elektrische Muskelaktivität misst,

- ein Bluetooth-Mikrocontroller zur Datenverarbeitung und Funkübertragung,

- sowie eine dehnbare Zink-Silberoxid-Batterie.

Die Elektronik ist in vier Schichten aufgebaut und mit einem elastischen Polymer vergossen. Das gesamte Modul ist nur wenige Millimeter dick, etwa 1,8 × 4,5 cm groß und bis über 20 % dehnbar. Die Batterie liefert etwa 3,1 V und rund 25 mAh, genug für mehr als 4 Stunden Betrieb bei einem Gesamtverbrauch von etwa 15 mW.

Funkreichweite und Temperatur halten sich ebenfalls im Rahmen: Das Bluetooth-Signal bleibt bis etwa 20 m stabil, und nach 30 Minuten Dauerbetrieb erwärmt sich die Elektronik nur bis knapp unter 28 °C – also deutlich unter typischer Hauttemperatur.

KI filtert das Bewegungschaos heraus

Der eigentliche Kniff steckt in der Auswertung. Statt zu hoffen, dass die Sensoren „saubere“ Signale liefern, akzeptiert das System das Chaos und trainiert eine KI genau darauf.

Im Kern arbeitet eine speziell angepasste Convolutional Neural Network (CNN) – ein neuronales Netz, das zeitliche Muster in den IMU-Daten erkennt. Die Forschenden haben dafür einen zusammengesetzten Datensatz gebaut:

- 19 definierte Unterarm-Gesten,

- jede Geste mehrfach in Ruhe aufgezeichnet,

- zusätzlich künstlich überlagert mit real gemessenen Störungen aus Laufen, Hochfrequenz-Vibrationen und Lagewechseln,

- plus Varianten mit unterschiedlichen Phasen, Geschwindigkeiten und Intensitäten.

Das Ergebnis: Die KI lernt nicht „eine Geste“, sondern „eine Geste plus typisches Störmuster“. In Tests erzielte die CNN hohe Kennzahlen: Recall, Präzision und F1-Score lagen in vielen Fällen über 0,9, die Spezifität bei über 0,99. Für neue, bislang nicht gesehene Störbedingungen blieb die Erkennungsrate über 94 %.

Chen fasst das so zusammen: „Durch die Integration von KI zur Echtzeitbereinigung verrauschter Sensordaten ermöglicht die Technologie die zuverlässige Steuerung von Maschinen durch alltägliche Gesten, selbst in sehr dynamischen Umgebungen.“

Transfer Learning: Schnelles Anpassen an neue Personen

Jede Person bewegt den Arm anders. Muskeltonus, Amplitude, Timing – all das variiert. Ein Modell, das nur auf eine Testperson trainiert ist, tut sich deshalb bei neuen Nutzer*innen schwer.

Die Gruppe löst das mit Transfer Learning. Erst trainiert sie das CNN auf Daten von fünf Personen. Danach wird das Modell mit wenigen Beispielen einer neuen Person nachjustiert – im Extremfall reichen zwei kurze Aufnahmen pro Geste, je einmal im Sitzen und im Liegen.

Der Effekt ist deutlich: Die minimale Erkennungsrate pro Geste steigt für neue Personen von etwa 51 % auf über 92 %. Gleichzeitig schrumpft der Aufwand zur Datenerfassung von Minuten auf wenige Sekunden.

Roboterarm im Laufschritt

Im nächsten Schritt prüften die Forschenden, ob das System mehr kann als „nur“ zu klassifizieren. Es sollte einen Roboterarm in Echtzeit steuern.

Dazu führt eine testende Person am Laufband definierte Gesten aus: Arm heben oder senken, nach links oder rechts drehen, Handgelenk rotieren. Parallel misst die EMG-Elektrode, ob die Hand greift oder loslässt.

Die IMU-Daten werden mit einem gleitenden Fenster von 1 s Länge und 0,25 s Schrittweite ständig ausgewertet. Das CNN liefert zu jedem Fenster eine Geste. Damit Fehlentscheidungen an Gestenübergängen nicht sofort zu falschen Bewegungen führen, reagiert der Roboterarm erst, wenn drei identische Vorhersagen nacheinander eintreffen. Die resultierende Latenz liegt insgesamt bei etwa 1,3 s – inklusive Datenerfassung, KI-Auswertung und Roboterreaktion.

Ohne KI schaukelt sich der Roboter im Test bei laufender Person deutlich auf. Mit dem trainierten Modell hingegen folgt er den gewünschten Gesten und kann sogar Flüssigkeit aus einem Reagenzglas in ein Becherglas umfüllen – während die Person läuft oder starken Vibrationen ausgesetzt ist. In Versuchen mit real aufgezeichneten Gesten unter Störbedingungen lag die Steuerungsgenauigkeit über 93 %.

Tests im „künstlichen Ozean“

Ursprünglich entstand die Idee, Militärtaucherinnen und -tauchern beim Steuern von Unterwasserrobotern zu unterstützen. Dort sind Störungen besonders komplex: Wellenbewegungen überlagern Gesten, die Dichte von Wasser verändert die Dynamik, und Kommunikationskanäle unter Wasser sind begrenzt.

Erste Messungen in der Mission Bay bei San Diego zeigten allerdings: In geschützten Gewässern sind die Wellen oft zu harmlos, um wirklich harte Testfälle zu erzeugen. Also zog das Team in den Scripps Ocean–Atmosphere Research Simulator um – einen Wellenkanal, in dem sich Höhe und Wellenlänge frei einstellen lassen.

Dort schwammen die Sensoren in einer Box an der Oberfläche, während der Kanal verschiedenste Seegänge nachstellte. Die gemessenen Wellenbewegungen wurden dann mit Gestensignalen überlagert und das CNN erneut trainiert. In Offline-Simulationen eines Tauchgangs erkannte das Modell die Gesten auch unter starken Wellen zuverlässig; alle Qualitätskennzahlen der Klassifikation näherten sich in den Tests dem Idealwert 1 an.

Interessanter Nebeneffekt: Seewasser reduziert den elektrischen Übergangswiderstand zwischen EMG-Elektrode und Haut, was die Qualität der Muskelsignale eher verbessert als verschlechtert.

Anwendungen: Von Reha bis Offshore-Anlage

Das Einsatzspektrum geht weit über das Labor hinaus:

- Rehabilitation und Assistenz: Menschen mit eingeschränkter Feinmotorik könnten Hilfsroboter mit groben Gesten steuern – selbst beim Gehen oder auf wackeligem Untergrund.

- Industrie und Einsatzkräfte: Bedienende könnten Werkzeuge, Drohnen oder Telepräsenzroboter freihändig steuern, etwa in vibrierenden Maschinenhallen oder bei Einsätzen mit Gefahrstoffen.

- Maritime Anwendungen: Tauchende und Operator*innen an der Oberfläche könnten Unterwasserroboter auch bei schwerem Seegang kontrollieren.

Chen sieht darin einen grundsätzlichen Schritt: „Diese Arbeit etabliert eine neue Methode für die Störfestigkeit von Wearable-Sensoren“, sagt er. „Sie ebnet den Weg für Wearable-Systeme der nächsten Generation, die nicht nur dehnbar und kabellos sind, sondern auch in der Lage sind, aus komplexen Umgebungen und individuellen Benutzern zu lernen.“

Ein Beitrag von: