Forschungsprojekt Robot}air{

Ziel des Projekts ist die Entwicklung und Evaluation eines prototypischen, kostengünstigen Boden-Luft-Servicerobotersystems für die Detektion und Ortung von Druckluftlecks und Isolationsschäden an Prozessöfen sowie für die Kartierung von Arbeitsumgebungsfaktoren. Dies dient einer nachhaltigen Ressourcen- und Energienutzung und trägt zur Sicherstellung gesunder Arbeitsbedingungen und zur Steigerung der Produktivität bei. Das System besteht aus einem teleoperiert fliegenden und einem teilautonom fahrenden Roboter, die beide mit intelligenten Multisensor-Modulen ausgestattet sind, sowie einem mobilen Leitstand. Dort wird aus den Sensorsignalen ein aussagekräftiges Lagebild erstellt und visualisiert. Ein Überblick über das System wird abgerundet von ersten Erprobungsergebnissen.

Bild: Hegger

Vor dem Hintergrund steigender Energiekosten sind Unternehmen immer mehr bemüht, bisher ungenutzte Energiesparpotenziale auszuschöpfen. Lecks in Druckluftanlagen und Isolationsschäden an Prozessöfen wurden aufgrund schlechter räumlicher Erreichbarkeit und geringer Auswirkungen auf die Produktionseinrichtungen und Produkte bisher oft vernachlässigt. Dabei ist insbesondere Druckluft relevant, da sie als teuerster Energieträger gilt und 10 % des elektrischen Energieverbrauchs in der EU ausmacht [1]. Untersuchungen gehen von typischen Leckraten von 20 bis 50 % aus [2], wobei die erreichbare Effizienzverbesserung bei ca. 20 % liegt [1], da nicht alle Lecks wirtschaftlich zu beseitigen sind. Durch regelmäßige Inspektionen können Lecks frühzeitig entdeckt und Verluste verringert werden. Ähnliches gilt für Isolationsschäden an Hochtemperaturanlagen wie Härteöfen. Für ähnliche Aufgaben wurden Ansätze zur robotergestützten Inspektion vorgeschlagen [3].

Gleichzeitig bleiben oft Verbesserungsmöglichkeiten bezüglich der Arbeitsumgebung unentdeckt, die über gesetzliche Vorschriften hinausgehen. Messungen werden in der Regel arbeitsplatzbezogen vorgenommen und nur dann aktualisiert, wenn Änderungen am betrachteten Arbeitsplatz vorgenommen werden. Unregelmäßige Einflüsse, Beispielsweise Materialanlieferungen, und Änderungen in der Umgebung, z. B. saisonale Einflüsse, bleiben dabei häufig unberücksichtigt. Heizung, Belüftung und Klimatisierung stellen mit 10 bis 20 % des elektrischen Energieverbrauchs außerdem einen weiteren wichtigen Kostenblock dar [2]. Typischerweise wird wegen der unklaren Raumklimasituation eine energetisch ungünstige Überbelüftungsstrategie gefahren, um Mindeststandards bei den Arbeitsbedingungen zu gewährleisten. Eine flächendeckende und regelmäßig aktualisierte multimodale Kartierung der lokalen Arbeitsumgebungsfaktoren kann hier einen Beitrag zur Sicherstellung gesunder Arbeitsbedingungen und zur Steigerung der Produktivität leisten.

Projektüberblick

Das Boden-Luft-Servicerobotersystem Robot}air{, ein Mensch-Maschine-System mit (teil-)autonomen mobilen Robotern [4], soll regelmäßige Inspektionen mit einer großen, räumlichen Abdeckung und kurzen Inspektionszyklen bei konstant hoher Inspektionsqualität ermöglichen. Technische Komponenten sind ein bodengebundener und ein luftgestützter Roboter, intelligente Multisensor-Module und ein mobiler Leitstand. Der Bodenroboter dient der kontinuierlichen teilautonomen Inspektion großflächiger Werkhallen, während der Flugroboter zur manuellen Überprüfung schlecht erreichbarer, hoch gelegener Bereiche dient. Wegen der beengten Platzverhältnisse beim Fliegen in einer Werkhalle wird die Position des Flugroboters vom Bodenroboter verfolgt und für Assistenzfunktionen, beispielsweise zur Kollisionsvermeidung, genutzt. Der mobile Leitstand dient der leitenden Kontrolle teilautonomer sowie der Teleoperation manueller Inspektionen. Letztere werden durch eine Augmented- Reality-Benutzungsschnittstelle in einer Durchsicht-Datenbrille unterstützt, die dem Operator die Sicht auf den Flugroboter und die gleichzeitige Wahrnehmung virtueller Informationen, beispielsweise freier Flugkorridore, erlaubt. Die Inspektionsergebnisse werden automatisch dokumentiert. Die Kommunikation zwischen beiden Robotern und der Leitwarte erfolgt über ein dediziertes WLAN-Mesh.

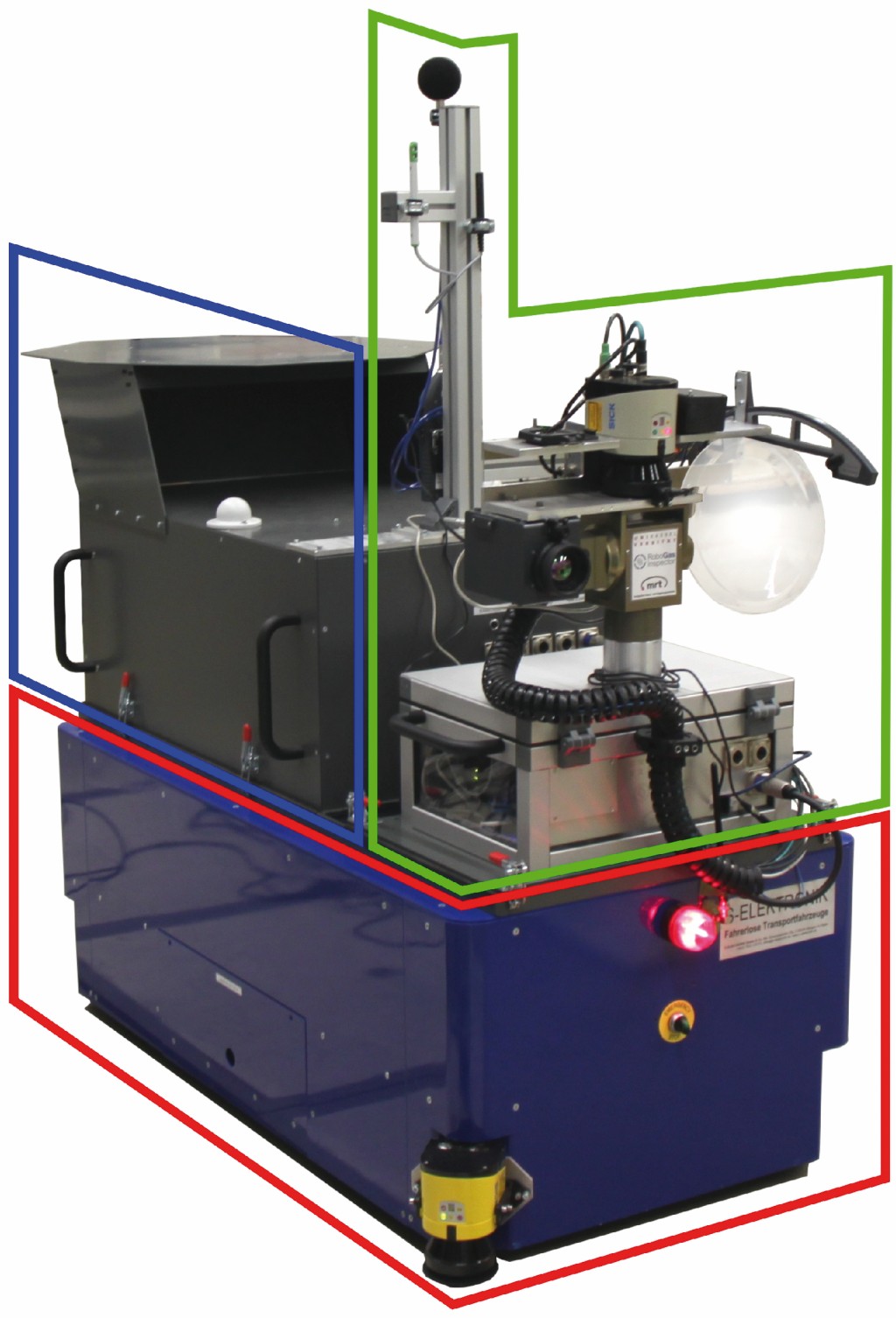

Der Bodenroboter (Bild 1) basiert auf einem fahrerlosen Transportsystem des Herstellers S-Elektronik, das mit zwei diagonal montierten Drehschemelantrieben ausgerüstet wurde und bei dem eine höhere Bauweise ausreichend Platz für die Energieversorgung eines Autonomiemoduls und eines Multisensor-Moduls bietet.

Bild 1 Bodenroboter auf Basis eines fahrerlosen Transportsystems (rot umrandet) mit gelbem Laserscanner, darauf Autonomiemodul (blau umrandet) und Multisensor-Modul mit Messsäule (grün umrandet).

Foto: Uni Kassel /Fraunhofer FKIE

Das Autonomiemodul realisiert die autonome Navigation des Bodenroboters. Zur Umgebungserfassung kommen dabei zwei 2-D-Laserscanner zum Einsatz, die in einer Diagonalkonfiguration eine 360°-Erfassung der Fahrebene wenige Zentimeter über dem Boden ermöglichen. Das Autonomiemodul dient außerdem der zentralen Koordination aller Roboter-Subsysteme und als zentraler Infrastruktur-Hub für Energieversorgung und Kommunikation.

Das intelligente Multisensor-Modul (Bild 2 links oben) wird frontal auf dem Bodenroboter positioniert, um den Erfassungsbereich der Sensorik zu maximieren.

Bild 2 Sensormodule des Bodenroboters sind das schwenk- und neigbare Multisensor-Modul (links oben), die schwenk- und neigbare Stereokamera (links unten) sowie die Messsäule für Arbeitsumgebungsfaktoren (rechts).

Foto: Uni Kassel /Fraunhofer FKIE

Die Sensorik ist auf einer Schwenk-Neigeeinheit (Schunk PW 90) montiert. Sie umfasst einen Ultraschallsensor mit Parabolspiegel (Sonotec Sonospot) und eine damit geometrisch kalibrierte Webcam für die Detektion und Ortung von Druckluftlecks sowie einen 2-D-Laserscanner (Sick LMS 151) und eine Thermografiekamera (VarioCAM hr head 600) für die 3-D-Kartierung der Oberflächentemperaturen. Eine an das Multisensor-Modul gekoppelte Messsäule zur Erfassung der Arbeitsumgebungsfaktoren (Schalldruckpegel, Lufttemperatur, Beleuchtungsstärke, Luftgeschwindigkeit und relative Luftfeuchte) kann auf dem Autonomiemodul montiert werden (Bild 2 rechts). Für den Einsatz des Flugroboters wird diese gegen eine schwenk- und neigbare Stereokamera getauscht (Bild 2 links unten), mit deren Hilfe die Position und Orientierung des Flugroboters verfolgt und in einem zuvor erstellten 3-D- Modell der Umgebung auf mögliche Kollisionen mit der Umgebung hin geprüft werden kann. Ein intelligentes Multisensor-Modul mit integriertem Messrechner steuert die Messvorgänge und ist für die Verarbeitung, Speicherung und Übertragung der erfassten Daten zuständig. Ultraschall- und Thermografiemessungen werden von mehreren Positionen aus im Stillstand aufgenommen, wobei mithilfe der Schwenk-Neigeeinheit ein vorgegebener Hallenbereich abgesucht wird. Die automatische Detektion und Ortung von Druckluftlecks basiert auf der Suche von Ultraschallpegelmaxima in mehreren Messvorgängen und der anschließenden Anwendung eines Triangulationsverfahrens. Zur 3-D-Kartierung der Oberflächentemperaturen werden die Daten der Wärmebildkamera und des 2-D-Laserscanners fusioniert, um eine texturierte Punktwolke mit Wärmeinformationen zu erstellen. Die in den einzelnen Messvorgängen generierten Punktwolken werden anschließend registriert, um ein 3-D-Thermogramm des gesamten Inspektionsbereichs zu generieren. Arbeitsumgebungsfaktoren werden fortlaufend mit einer konfigurierbaren Frequenz, z. B. 2 Hz, erfasst, in der Leitwarte visuell aufbereitet und durch den Operator interpretiert.

Der Flugroboter (Bild 3) basiert auf dem modifizierten Hexakopter Aibot X6 mit modularem Nutzlastsystem des Herstellers Aibotix. Aufgrund seiner im Vergleich zum Bodenroboter geringeren Nutzlast verfügt er über austauschbare Sensormodule (Bild 4) für Ultraschall- und Thermografiemessungen.

Bild 3 Flugroboter mit neigbarem Nutzlastträger zwischen dem Landegestell, darauf das Thermografiemodul.

Foto: Uni Kassel /Fraunhofer FKIE

Bild 4 Der Flugroboter kann entweder mit dem Ultraschall- (oben), dem Thermographie- (mittig) oder dem 3-D-Lasermodul (unten) ausgestattet werden.

Foto: Uni Kassel /Fraunhofer FKIE

Eine alternative Bestückung mit einem 3-D-Laserscanner ermöglicht die Erfassung geometrischer Daten zur Vervollständigung von Anlagenmodellen. Für die Ortung des Flugroboters mithilfe der Stereokamera des Bodenroboters sind farbige Positionsleuchten in einer definierten Konfiguration an der Unterseite des Flugroboters angebracht.

Die Sensormodule des Flugroboters setzen die leichtesten verfügbaren Sensoren ein, um die Flugzeit zu maximieren. Das Ultraschallmodul wird oben auf dem CFK-Rahmen des Flugroboters montiert. Neben einem Ultraschallsensor mit akustischem Horn verfügt es über eine Webcam und eine Neigeeinheit. Das Thermografiemodul umfasst eine Wärmebildkamera (Optris PI-450) und einen Tiefensensor (Asus Xtion Pro Live). Das 3-D-Lasermodul verfügt über einen rotierenden 3-D-Laserscanner (Velodyne Lidar HDL32E). Ein mitgeführter Rechner wird für die Vorverarbeitung, Speicherung und Übertragung der erfassten Messdaten sowie für die Verwaltung der Messaufgaben benutzt. Ultraschall- und Thermografiemessungen werden vom Piloten über die Fernbedienung ausgelöst. Detektion und Ortung von Druckluftlecks erfolgen hierbei manuell mittels akustischer Signale. Die Erstellung der 3-D-Thermogramme erfolgt in Echtzeit auf der Basis des Kinect-Fusion-Algorithmus.

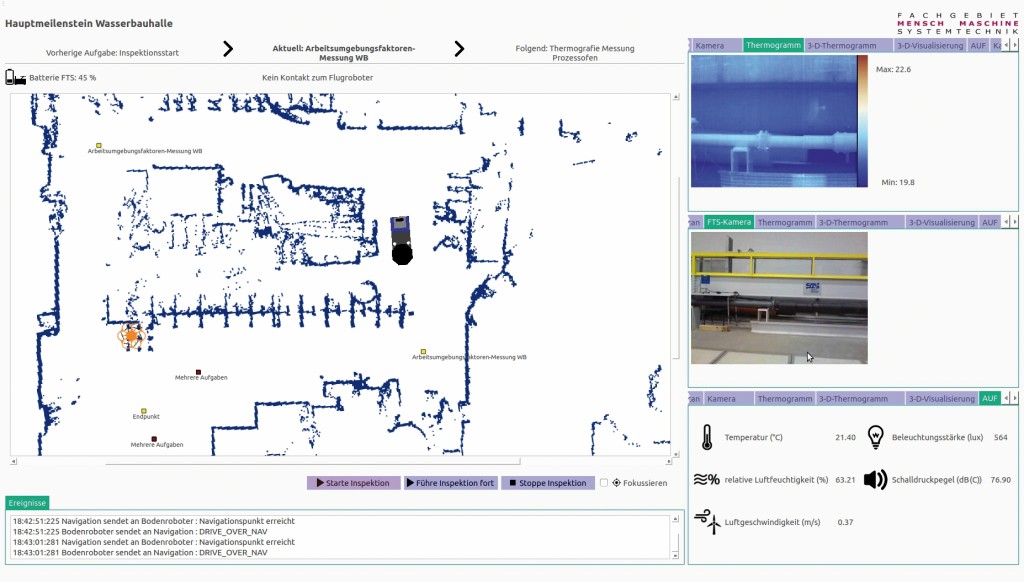

Der Einsatz der Roboter wird mithilfe einer grafischen Benutzungsschnittstelle geplant und überwacht (Bild 5).

Bild 5 Screenshot der Benutzungsschnittstelle während einer Überwachungsaufgabe.

Foto: Uni Kassel /Fraunhofer FKIE

Sie dient außerdem der automatischen Dokumentation der Ergebnisse. Die Benutzungsschnittstelle bietet für jede der drei Hauptaufgaben Planung, Überwachung und Dokumentation eine eigene Ansicht, sodass dem Operator alle notwendigen Visualisierungs- und Interaktionselemente sowie Assistenzfunktionen aufgabengerecht zur Verfügung stehen. Die Benutzungsschnittstelle wurde in einem iterativen Entwicklungsprozess erstellt und jeder Prototyp mittels einer Nutzer-Studie auf seine Gebrauchstauglichkeit hin evaluiert [5]. Mithilfe der Benutzungsschnittstelle werden Messaufgaben definiert und die Art, Ort und sonstige Parameter einer Messung festgelegt. Aus einem Pool von Messaufgaben kann der Operator eine Liste durchzuführender Aufgaben wählen. Das System plant anschließend eine optimale Route, die der Operator überprüfen und zur (teil-)autonomen Ausführung freigeben kann.

Der Einsatz des Flugroboters zur Durchführung von Messaufgaben wird anders behandelt. Soll eine Messaufgabe durchgeführt werden, muss der Operator den Flugroboter sowie erforderliches Zubehör (RC-Fernsteuerung, ggf. Ersatzakkus, Stereokamera oder Austausch-Sensormodule) zur Position des Bodenroboters bringen und dort manuell gesteuert und auf Sicht die luftgestützte Messung ausführen. Zur Kontrolle der Messergebnisse und zur Wiederaufnahme der (teil)autonomen Inspektion ist ein Zugriff auf die Benutzungsschnittstelle und zum Austausch von Nutzlastmodulen und Akkus zumindest eine Montagefläche, ggf. auch Werkzeug, notwendig. Um die Benutzungsschnittstelle, das benötigte Material und eine Arbeitsfläche am Einsatzort verfügbar zu haben, wird ein mobiler Leitstand eingesetzt (Bild 6).

Bild 6 Mobiler Leitstand einsetzbar als Bildschirm- und als Montagearbeitsplatz.

Foto: Uni Kassel /Fraunhofer FKIE

Neben diversen Staufächern für den Materialtransport, einer Transporthalterung für den Flugroboter und einem höhenverstellbaren Bildschirmarbeitsplatz für die leitende Kontrolle, lässt sich der Leitstand auch als Montagearbeitsplatz für anfallende Reparaturen oder Umbauten nutzen. Die Auslegung des Leitstands wurde CAD-basiert auf ihre Ergonomie hin evaluiert.

Erprobung grundlegender Funktionalitäten

Nach zwei Dritteln der Projektlaufzeit umfasst der planungsgemäße Entwicklungsstand die prototypische Realisierung der Grundfunktionalitäten und ihre Erprobung unter Laborbedingungen. Diese wurden im November 2014 erfolgreich demonstriert und sollen im Folgenden vorgestellt werden.

Softwareseitig setzt das Projekt auf dem Open-Source-Framework ROS (Robot Operating System) auf. Für die Ansteuerung der Bodenroboter-Plattform wurden die Einzelkomponenten der Antriebe und Encoder unter Berücksichtigung der Robotergeometrie zu einem logischen Gesamtmodell kombiniert und ermöglichen so einen quasi-holonomen Bewegungsraum, der allerdings durch fehlende Freiheitsgrade der Drehschemelantriebe bedingt durch fixe Kabellängen und Anschlussmodalitäten in der Rotation limitiert ist. Darauf aufbauend wird als Grundlage der autonomen Navigation der ROS-Navigation-Stack genutzt.

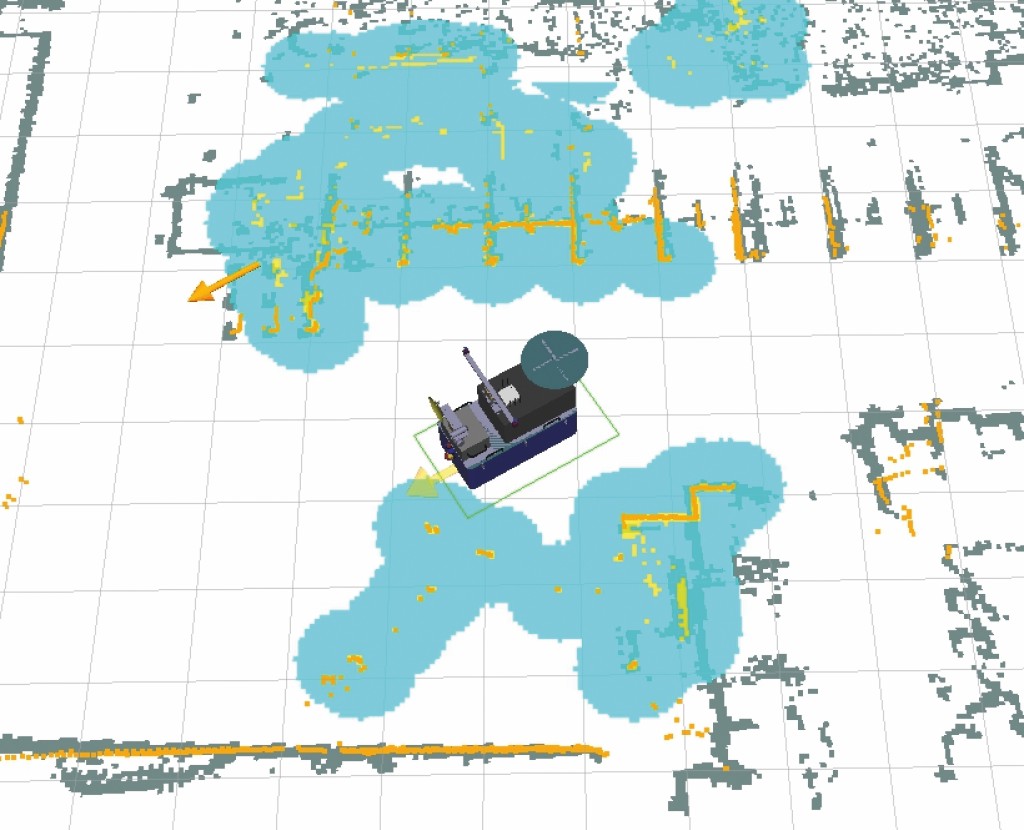

Die Selbstlokalisierung des Bodenroboters erfolgt durch einen passend parametrierten Partikelfilter, der die Umgebungsinformationen der zur Fahrebenenüberwachung eingesetzten Laserscanner mit einer a priori aufgenommen Anlagenkarte abgleicht (Bild 7).

Bild 7 Umgebungsinformationen des autonomen Navigationssystems des Bodenroboters mit a priori aufgenommener Karte (grau mit weißem Hintergrund), aktuell detektierten Hindernissen (orange), daraus resultierenden Sicherheitsabstandszonen (cyan) und durch die Lokalisierung festgestellter Ausrichtung und Position des Bodenroboters (Robotermodell).

Foto: Uni Kassel /Fraunhofer FKIE

Die Bewegungstrajektorie wird lokal ebenfalls auf der Basis dieser Informationen sowie anhand der durch die geplanten Messaufgaben vorgegebenen Zielpunkte generiert. Die Trajektorie wird fortlaufend überprüft und angepasst, um auf Hindernisse zu reagieren und diese, wenn möglich, zu umfahren.

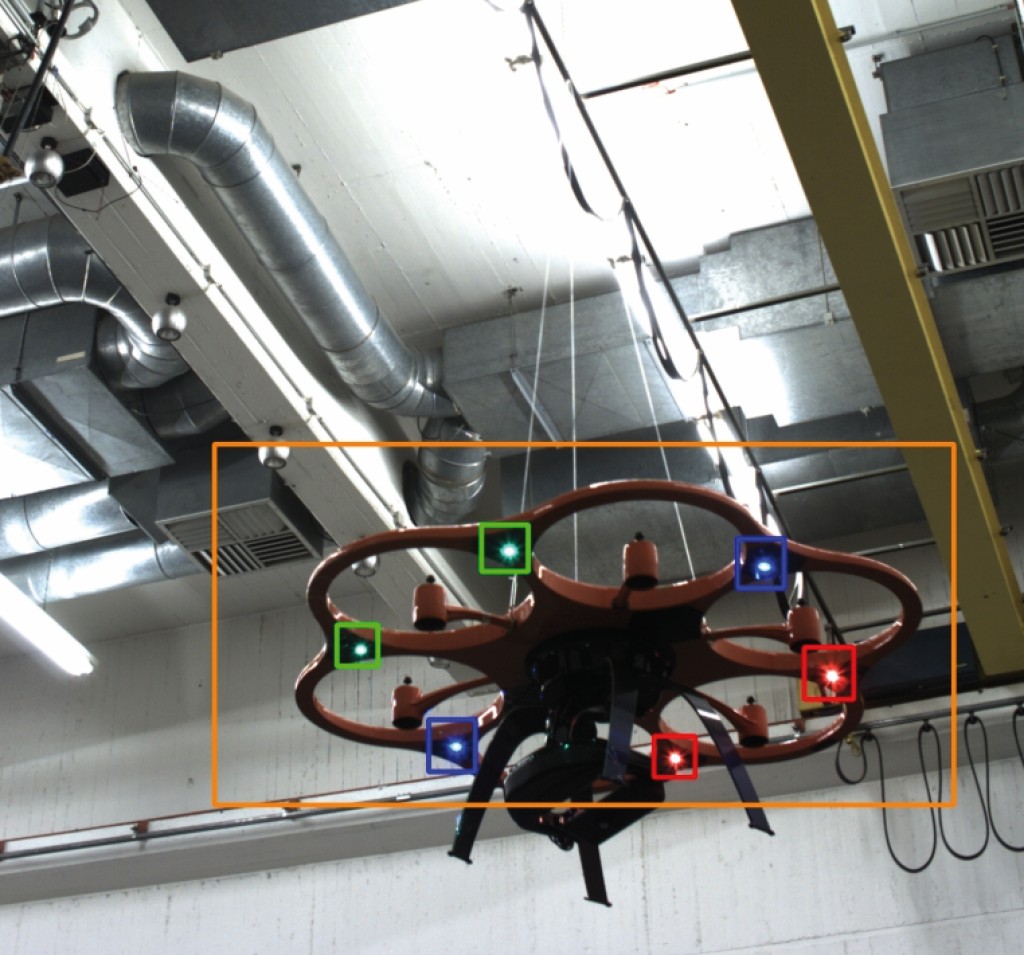

Die Lokalisierung des Flugroboters mithilfe der Stereokamera auf dem Bodenroboter basiert auf den zeitlich synchronisierten Bildern beider Kameras. Aus diesen wird mittels optischer Triangulation und Detektionsalgorithmen die Flugroboterposition relativ zum Bodenroboter bestimmt. Die Kameras werden dabei mittels reaktiver Steuerung einer Schwenk-Neigeeinheit dem Flugroboter nachgeführt. Um den zu durchsuchenden Bildbereich und damit die benötigte Ausführungszeit des Verfahrens zu verringern, wird durch eine Vordetektion anhand von optischen Parametern des Flugroboters zunächst eine Region-of-Interest (Bild 8) in den hochaufgelösten Kamerabildern bestimmt.

Bild 8 Visualisierung der Detektion des Flugroboters mit durch Vordetektion ermitteltem relevantem Bildbereich (orange umrandet) und Detektion der LED (rot, grün, blau umrandet).

Foto: Uni Kassel /Fraunhofer FKIE

In diesem Bildbereich wird anschließend basierend auf dem geometrischen Modell des Flugroboters und der bekannten Konfiguration der farbigen LED eine Schätzung der Orientierung und Position vorgenommen. Im Detail kommen hierfür Techniken der Stereo-Bildverarbeitung in Kombination sowohl mit einem Unscented-Kalman-Filter für Single-Hypothesen-Tracking, als auch mit einem Partikelfilter für Multi-Hypothesen- Tracking zum Einsatz.

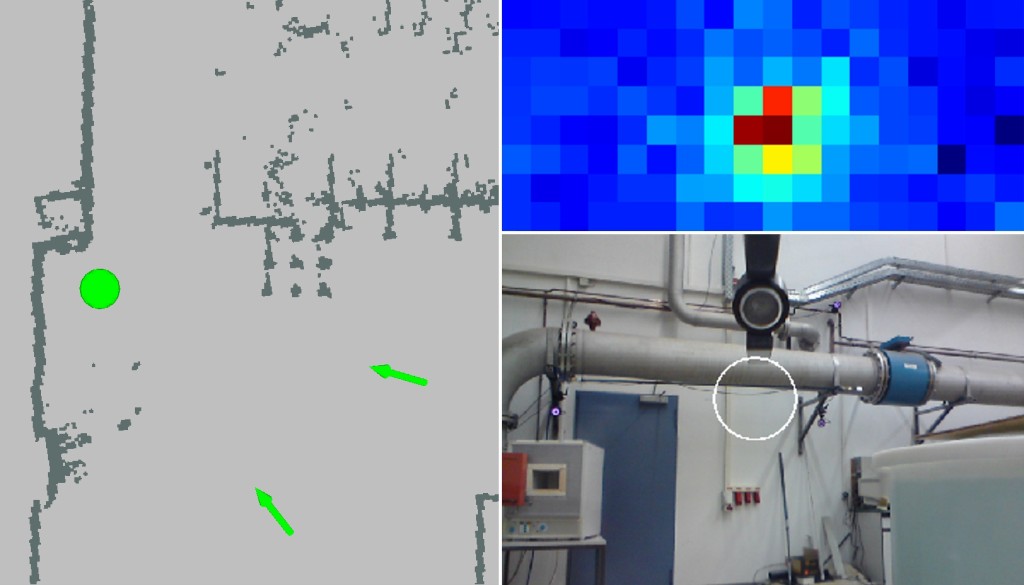

Die Druckluftlecksuche mit dem Bodenroboter gliedert sich in zwei Stufen: Richtungsschätzung und Lokalisierung. Die Schätzung der Richtung, in der das Leck vermutet wird, wurde mittels einer dynamischen rasterbasierten Suchstrategie [6] realisiert. Zunächst wird eine schnelle Rastersuche mit großen Abständen zwischen den Rasterpunkten durchgeführt, bei der aufgrund der großen Empfangsfläche des Parabolspiegels dennoch eine vollständige Abdeckung des Zielgebiets gewährleistet ist. In dem daraus resultierenden Intensitätsbild werden lokale Maxima bestimmt, in deren Umfeld anschließend zur Verbesserung der Richtungsschätzung eine zweite feinere Rastersuche durchgeführt wird. Die Lokalisierung eines Lecks im Raum erfolgt mittels Triangulation auf der Basis zweier Detektionen, d. h. Position und Orientierung des Sensors zum Leck, aus unterschiedlichen Positionen. Die automatische Detektion und Lokalisierung wurden erfolgreich demonstriert. Eine exemplarische Ergebnisdarstellung zeigt Bild 9.

Bild 9 Ansicht des Entwicklers bei einer Leckortung mit 2-D-Karte der Umgebung (links), in der Detektionen von zwei Positionen aus (grüne Pfeile) und die geschätzte Leckposition (grüner Kreis) markiert sind, Intensitätsverteilung der Ultraschallpegel (rechts oben) sowie mit einem Foto mit kreisförmiger Leckmarkierung (rechts unten).

Foto: Uni Kassel /Fraunhofer FKIE

Neben der Position des Lecks und der beiden Detektionen werden die Intensitätsverteilung der Ultraschall-Rastersuche und ein Kamerabild mit Markierung des Lecks gespeichert. Die Genauigkeit der Positionsschätzung hängt stark von der Selbstlokalisierungsgenauigkeit des Bodenroboters ab. In den Tests war die Standardmessunsicherheit < 1 m.

Die Lecksuche mit dem Flugroboter wird manuell durchgeführt, wobei der Operator den Ultraschallsensor auf das Zielgebiet ausrichtet. Mittels Kopfhörern nimmt er dabei das in Hörschall abwärtsgemischte Ultraschallsignal wahr. Hört er ein lecktypisches Signal, richtet er den Sensor auf die Geräuschquelle aus und löst die Detektion mit einem Trigger manuell aus. Dabei wird ein Bild mit markiertem Leck sowie Position und Orientierung des Sensors gespeichert. Auf der Basis von zwei Detektionen kann ebenfalls eine Triangulation der Leckposition durchgeführt werden. Die Genauigkeit der Ergebnisse hängt dabei wesentlich von der Erfahrung des Operators und der Genauigkeit der Lokalisierung des Flugroboters ab. Während der Tests wurde der Flugroboter mit einem Motion-Tracking-System lokalisiert und von einem erfahrenen Piloten gesteuert, sodass die Ergebnisse vergleichbar mit denen des Bodenroboters waren.

Zur Detektion von Isolationsschäden werden 3-D-Thermogramme erstellt, da sie eine bessere Darstellung des Temperaturprofils eines Objekts bieten. Zur Erfassung der 3-D-Geometrie wurden zwei Tiefensensoren erprobt: Ein 2-D-Laserscanner (Sick LMS 151) auf dem Bodenroboter und ein Tiefensensor (ASUS Xtion Pro Live) auf dem Flugroboter. Der Laserscanner bietet eine deutlich größere Reichweite und kleinere Messunsicherheit (bei großen Entfernungen), hat aber eine niedrigere räumliche Auflösung, eine geringere Abtastrate und muss bewegt werden, um 3-D-Punktwolken zu generieren. Der Tiefensensor ist hingegen leichter und kleiner. Um die intrinsischen Parameter des Lochkameramodells der Wärmebildkamera zu ermitteln, wurden diese kalibriert. Zudem wurden die räumlichen Beziehungen zwischen den Wärmebildkameras und den jeweiligen Entfernungssensoren sowie zwischen der Bodenroboter-Wärmebildkamera und der Schwenk-Neigeeinheit des Sensormoduls abgeschätzt. Für die Kalibrierungen wurden unterschiedliche Verfahren, beispielsweise [7], eingesetzt. Wegen der schlechteren Auflösung und der geringeren Schärfentiefe von Wärmebildkameras sind die Ergebnisse der Kamerakalibrierung nicht so präzise wie bei konventionellen Videokameras. Die geometrische Kalibrierung zwischen Wärmebildkamera und Tiefensensor ist zusätzlich von der Ungenauigkeit des Tiefensensors betroffen.

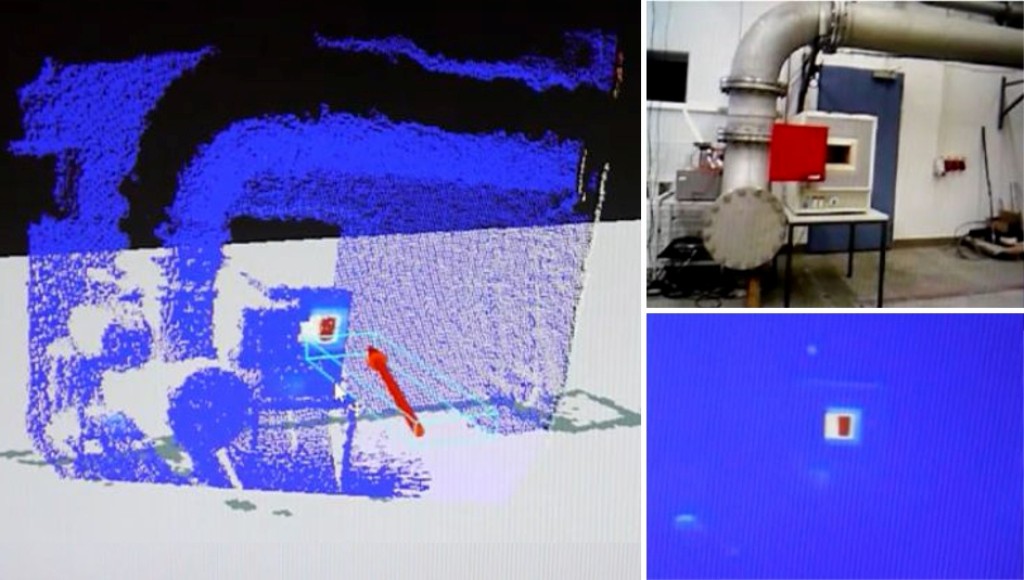

Die von verschiedenen Positionen des Bodenroboters aus aufgezeichneten Punktwolken werden mit dem Iterative-Closest-Point-Verfahren registriert. Außerdem müssen die Temperaturwerte, die am selben Punkt aus unterschiedlichen Perspektiven gemessen wurden, sinnvoll kombiniert werden. Dabei müssen die Messbedingungen, z. B. Entfernung, Einfallswinkel, Betrachtungswinkel und Kamerageschwindigkeit, berücksichtigt werden. Bild 10 zeigt die Ansicht des Entwicklers während der Erstellung eines 3-D-Thermogramms von einem Prozessofen. Der Boden und die darauf gezeichnete 2-D-Navigationskarte werden jeweils in Weiß und Grau dargestellt.

Bild 10 Ansicht des Entwicklers während der Erstellung eines 3-D-Thermogramms eines Prozessofens mit texturierter Punktwolke (links), Videobild (rechts oben) und 2-D-Thermogramm (rechts unten).

Foto: Uni Kassel /Fraunhofer FKIE

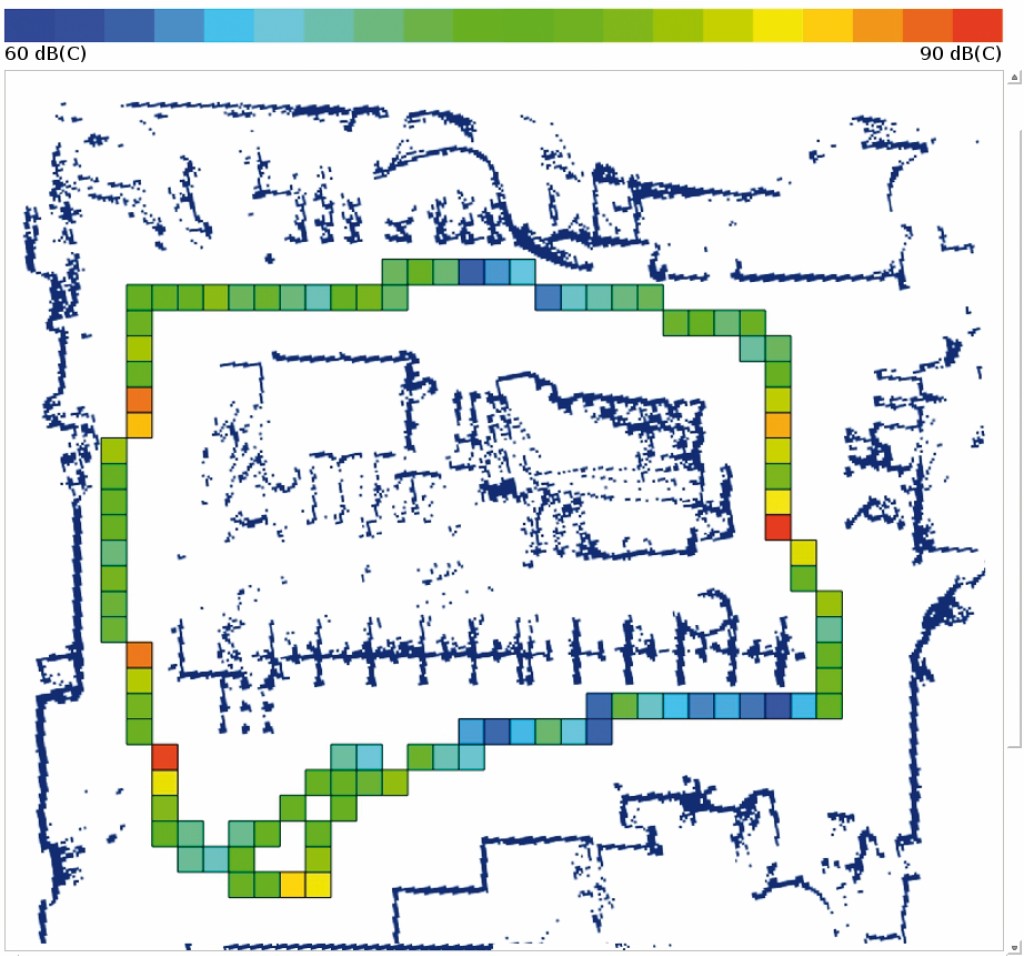

Die während einer Inspektionsfahrt aufgezeichneten Arbeitsumgebungsfaktoren Lufttemperatur, relative Luftfeuchte, Luftgeschwindigkeit, Schalldruckpegel und Beleuchtungsstärke werden im Anschluss vom Operator interpretiert. Eine Anforderungsanalyse ergab, dass dabei Spitzen des Schalldruckpegels, beispielsweise beim Absetzen von Gabelstaplern, eine mangelhafte Beleuchtung und unbehagliche klimatische Bedingungen in der gesamten Werkhalle, also insbesondere auch abseits der Hauptarbeitsplätze, als besonders relevant eingeschätzt werden [8].

Um eine effiziente Auswertung zu ermöglichen, wird der Operator in der Benutzungsschnittstelle durch eine geeignete Farbgebung, beispielsweise anhand gesetzlich vorgegebener Grenzwerte, unterstützt. Gesetzliche Grenzwerte für den Spitzenschalldruckpegel finden sich z. B. in [9]. Bezüglich anderer Arbeitsumgebungsfaktoren, beispielsweise des Klimas, gibt es hingegen keine eindeutigen gesetzlichen Vorgaben. Für diese Fälle lassen sich die Grenzwerte frei konfigurieren. Grundsätzlich ist bei der Bewertung des Klimas geboten, auch zusammenfassende Größen, sog. Klimasummenmaße, zu betrachten, da die subjektiv empfundene Behaglichkeit nicht von einer Messgröße allein bestimmt wird, so können z. B. niedrige Temperaturen bei Sonnenschein dennoch als angenehm empfunden werden. Daher lassen sich sowohl die einzelnen Messgrößen als auch die Klimasummenmaße anzeigen. Die erhobenen Messgrößen erlauben aktuell die Berechnung von Effektivtemperaturen, beispielsweise der Normaleffektivtemperatur nach [10]. Geprüft wird aktuell die ergänzende Messung der Wärmestrahlung, da an den Außenwänden sowie an bestimmten Maschinen relevante Wärmestrahlungswerte erwartet werden.

Die erfassten Messwerte werden in einem Kataster dargestellt, dessen räumliche Granularität sich beliebig parametrieren lässt. Dabei werden mehrere Messwerte innerhalb einer Katasterzelle geeignet zusammengefasst, beispielsweise werden bei Spitzenschalldruckpegeln die Maximalwerte eingetragen. Die Einstellung der Granularität ermöglicht dem Operator eine grobe Sichtung der umfangreichen Messdaten und eine Detailbetrachtung problematischer Hallenbereiche. Die bisherigen Tests unter Laborbedingungen bestätigten die Eignung des Systems. Künstlich erzeugte Problemzonen der Arbeitsbedingungen wurden in den Katastern effizient gefunden. Bild 11 zeigt exemplarisch das Kataster der Spitzenschalldruckpegel in einer Laborumgebung. Erkennbar sind die zurückgelegte Trajektorie und eine einfache Farbkodierung zwischen gemessenem Minimal- und Maximalwert.

Bild 11 Ausschnitt der Dokumentationsansicht der Benutzungsschnittstelle mit Kataster der Spitzenschalldruckpegel in einfacher Farbkodierung zwischen Minimal- und Maximalmesswert.

Foto: Uni Kassel /Fraunhofer FKIE

Zusammenfassung und Ausblick

Der im Projekt Robot}air{ entwickelte Prototyp eines Boden-Luft-Servicerobotersystems ist in der Lage, Druckluftlecks zu detektieren und zu orten, Isolationsschäden an Prozessöfen sichtbar zu machen und Arbeitsumgebungsfaktoren zu kartieren. Neben autonom ausgeführten regelmäßigen und großflächigen Inspektionen bietet der Flugroboter-Einsatz die Möglichkeit, auch schwer erreichbare Anlagenteile schnell und mit geringem Aufwand zu inspizieren. Die Grundfunktionalitäten des Systems wurden Ende 2014 unter Laborbedingungen erfolgreich getestet und demonstriert. Für das erste Quartal 2015 eingeplante Tests unter Feldbedingungen sollen sicherstellen, dass auch ein produktiver Einsatz möglich ist. Um die Akzeptanz in der Belegschaft zu fördern, werden die Mitarbeiter im Rahmen von Nutzerstudien an das technische System herangeführt. Die Akzeptanz des Managements wird durch eine Kosten-Nutzen-Abschätzung adressiert, die auf Vergleichsmessungen der Leckraten mit und ohne Einsatz des Servicerobotersystems basiert. Dazu sollen festinstallierte Sensoren in das Druckluftsystem des Anwendungspartners eingebracht werden. TS 437

Danksagung

Das diesem Bericht zugrunde liegende Vorhaben wurde mit Mitteln des Bundesministeriums für Bildung und Forschung unter dem Förderkennzeichen 01IM12007 gefördert. Die Verantwortung für den Inhalt dieser Veröffentlichung liegt bei den Autoren. Die Autoren danken allen anderen Projektpartnern für ihre wertvolle Unterstützung.

Literaturverzeichnis

[1] Radgen, P.; Blaustein, E. (Hrsg.): Compressed air systems in the European Union – Energy, emissions, savings potential and policy actions. Stuttgart: LOG_X 2001.

[2] Galitsky, C.; Worrell, E.: Energy efficiency improvement and cost saving opportunities for the vehicle assembly industry. LBNL- 50939-Revision. Berkeley: Ernest Orlando Lawrence Berkeley National Lab, Environmental Energy Technologies Division, 2008.

[3] Kroll, A: A survey on mobile robots for industrial inspection. Int. Conf. on Intelligent Autonomous Systems (IAS10), 2008, S. 406-414.

[4] www.robotair.de

[5] Ziegner, D.; Hegenberg, J.; Herrmann, R., Schmidt, L.: Evaluation und Adaption einer Leitstand-Benutzungsschnittstelle für ein Boden-Luft-Servicerobotiksystem. In: Gesellschaft für Arbeitswissenschaft e. V. (Hrsg.): Verantwortung für die Arbeit der Zukunft: 61. Kongress der Gesellschaft für Arbeitswissenschaft. Karlsruhe 2015. Dortmund: GfA-Press, 2015, S. 1-6 (C.4.5).

[6] Baetz, W.; Kroll, A.; Bonow, G.: Mobile robots with active IR-optical sensing for remote gas detection and source localization. In: IEEE International Conference on Robotics and Automation. Kobe 2009. New York: IEEE 2009, S. 2773-2778.

[7] Vasconcelos, F.; Barreto, J. P.; Nunes, U.: A minimal solution for the extrinsic calibration of a camera and a laser-rangefinder. In: IEEE Transactions on Pattern Analysis and Machine Intelligence 34 (2012) Nr. 11, S. 2097-2107.

[8] Ziegner, D.; Herrmann, R.; Hegenberg, J.; Schmidt, L.: Anforderungsanalyse für ein Boden-Luft-Servicerobotiksystem zur Inspektion von industrieller Druckluftversorgung und Verbesserung von Arbeitsumgebungsfaktoren. In: Gesellschaft für Arbeitswissenschaft e. V. (Hrsg.): Gestaltung der Arbeitswelt der Zukunft: 60. Kongress der Gesellschaft für Arbeitswissenschaft. München 2014. Dortmund: GfA-Press, 2014, S. 115-117.

[9] Technische Regeln zur Lärm- und Vibrations-Arbeitsschutzverordnung, Teil 1: Beurteilung der Gefährdung durch Lärm. GMBl. Nr. 18-20 vom 23. März 2010, S. 362.

[10] DIN 33403: Klima am Arbeitsplatz und in der Arbeitsumgebung – Teil 3: Beurteilung des Klimas im Warm- und Hitzebereich auf der Grundlage ausgewählter Klimasummenmaße. Berlin: Beuth Verlag 2011.

Jens Hegenberg, Roman Herrmann, Daniela Ziegner, Ludger Schmidt, Fachgebiet Mensch-Maschine-Systemtechnik, Universität Kassel. Thomas Günther, Antonio Ordoñez Müller, Andreas Kroll, Fachgebiet Mess- und Regelungstechnik, Universität Kassel. Thomas Barz, Dirk Schulz, Kognitive Mobile Systeme, Fraunhofer FKIE, Wachtberg.