Big Data in der Kleinserien-Produktion

Die steigende Nachfrage nach kundenindividuellen und komplexeren Produkten steht im drastischen Gegensatz zum aktuellen Fachkräftemangel. Denn in der Einzel- und Kleinserienfertigung der metallverarbeitenden Industrie ist vor allem in der Planungsphase noch ein hoher manueller Aufwand erforderlich. Das AICoM-Forschungsprojekt hat sich zum Ziel gesetzt, den Weg zur autonomen Fräsmaschine aufzuzeigen. In diesem Beitrag liegt der Schwerpunkt auf der Rolle der Daten und deren Nutzung mit KI-Verfahren. Es wird erläutert, warum Big Data für die Einzelteilfertigung notwendig ist.

![Bild 1. Stufenmodell Autonome Werkzeugmaschinen. Grafik: [2] 2](https://www.ingenieur.de/wp-content/uploads/2024/04/W_BMBF_Projekt-AIC_Bild-1-1200x600.jpg)

Bild 1. Stufenmodell Autonome Werkzeugmaschinen. Grafik: [2] 2

ProLern AICoM – Challenges on the way to the autonomous milling machine

Abstract: The increasing demand for customized and more complex products is in stark contrast to the current shortage of skilled workers. This is because individual and small series production in the metalworking industry still requires a great deal of manual labor, especially in the planning phase. The AICoM research project has set itself the goal of demonstrating the path to autonomous milling machines. In this report, the focus is on the role of data and its utilization with AI processes. You will learn why big data is necessary for single-part production.

1 AICoM Projektmotivation

1.1 Herausforderungen in der Einzelteilproduktion

Der Maschinenbau steht vor der Herausforderung, individuelle und komplexe Produkte effizient zu fertigen, während Kostendruck und Fachkräftemangel zunehmen. Die traditionellen Zerspanungsstrategien reichen nicht mehr aus, da sie weder effizient noch flexibel genug sind. Es fehlt oft an tiefgehendem Prozessverständnis, was zu geringer Flexibilität bei der Anpassung an neue Anforderungen führt. Diese konservativen Ansätze können zwar kurzfristig sicher und vertraut erscheinen, verhindern jedoch langfristig die Optimierung der Produktionsprozesse und die volle Ausschöpfung des Potenzials der Maschinen. Das Konzept „First Part Good Part“, das auf die Produktion von fehlerfreien Teilen im ersten Durchlauf abzielt, ist für die Effizienzsteigerung und Kostensenkung entscheidend. Die Optimierung dieser Prozesse erfolgt bisher manuell und hängt stark vom Know-how und der Innovationsbereitschaft des Personals ab. Künstliche Intelligenz könnte ein wirksames Werkzeug sein, um die Optimierungszyklen zu unterstützen und so die Wirtschaftlichkeit zu verbessern.

1.2 Forschungsprojekt AICoM

Diese Herausforderungen der Kleinserien-Produktion ist die Motivation für das geförderte Forschungsprojekt AICoM – Artificial Intelligence Controlled Milling, welches eines von 14 geförderten Verbundvorhaben im Rahmen der BMBF Bekanntmachung ProLern ist. ProLern steht für Lernende Produktionstechnik – Einsatz künstlicher Intelligenz (KI) in der Produktion. Das AICoM-System bietet die Möglichkeit, die CAD/CAM-Fertigungskette bis hin zur Produktfertigung zu optimieren. Das AICoM-System mit einer CNC-gesteuerten Werkzeugmaschine zu verbinden, ermöglicht eine „lernende Werkzeugmaschine“ für die spanende Fertigung zu schaffen [1]. Diese lernende Maschine ist in der Lage, aufgrund der gewonnenen Erfahrungen die Planung und CNC-Programm-Entwicklung selbständig anzupassen. Das AICoM Projekt, gestartet am 01.06.2021, befindet sich aktuell in der letzten Phase. Dieser Beitrag vermittelt einen Zwischenstand, insbesondere wird näher auf die Rolle der Daten und den Einsatz von Maschine-Learning (ML) Verfahren (Segment der KI-Landschaft) eingegangen.

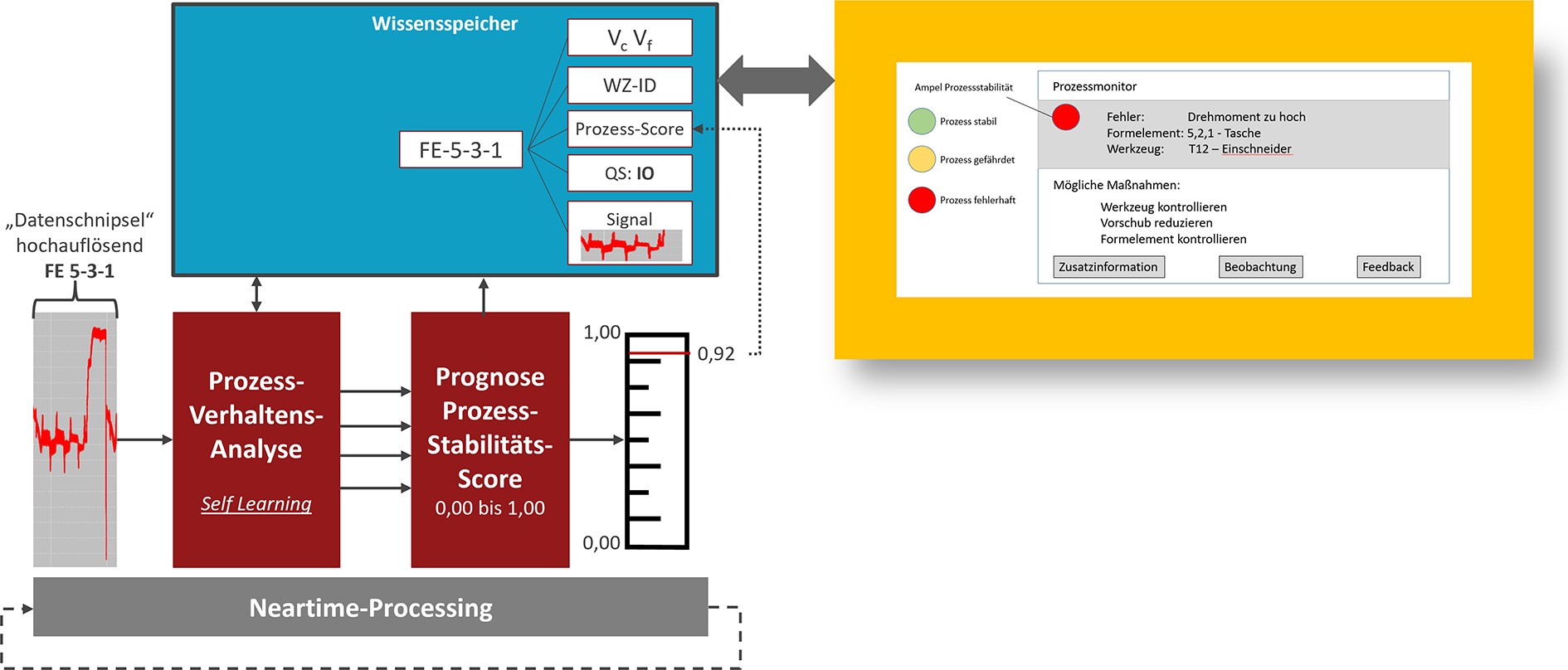

AICoM lässt sich sehr gut in das Stufenmodell (Bild 1) autonomer Werkzeugmaschinen einordnen. [2]. Die Ausgangslage entspricht ungefähr der Stufe 2, die Stufe 3 entspricht dem AICoM Ansatz. Stufe 4 lässt sich in der Projektlaufzeit nicht umsetzen. Das notwendige Wissen aus vielen unterschiedlichen geplanten und produzierten Werkstücken für eine vollständige autonome Planung und Regelung ist noch zu gering.

Die in Bild 1 gelb markierten Funktionen sind die u. a. zwei Kernfunktionen der AICoM Lösung. Die Planung, d. h. alle Schritte von der Zeichnung bis hin zum Bereitstellen des NC-Programms für das kundenindividuelle Werkstück wird teilautonom, d. h. mit minimalen Experten-Aufwand erstellt. Umso umfangreicher das Wissen aus der Zerspanung und dem Prozessergebnis ist, umso mehr reduziert sich dieser manuelle Expertenaufwand – die Annäherung an Stufe 4 findet statt.

1.3 Die wesentlichen Ziele der AICoM-Lösung

Das Projekt AICoM zielt darauf ab, die zerspanende Produktion durch die Integration neuer Technologien grundlegend zu verbessern. Diese Verbesserungen führen zu einer höheren Wettbewerbsfähigkeit durch geringere Lohnstückkosten, da der manuelle Aufwand für die Erstellung von CNC-Programmen stark reduziert wird. Die Technologie ermöglicht eine Annäherung an eine Null-Fehler-Produktion und gewährleistet, dass das erste produzierte Teil bereits den Qualitätsanforderungen entspricht (First Part Good Part), was Zeit und Ressourcen spart. Die Nutzung eines virtuellen Zwillings, basierend auf KI und dichten Sensordaten, erlaubt präzise Vorhersagen über die Laufzeit und Qualität von Bauteilen. Durch einen kontinuierlichen Verbesserungsprozess sowie das Speichern von Expertenwissen wird nicht nur die Effizienz gesteigert, sondern auch die Qualität und Nachhaltigkeit des Produktionsprozesses gesichert. Moderne CNC-Maschinen, wie die MX Cube Serie des assoziierten Partners Datron, ermöglichen eine hochgenaue Prozessüberwachung ohne externe Messtechnik und die schnelle Erkennung von Abweichungen, wobei KI-Verfahren zur Optimierung des Prozesses beitragen.

1.4 AICoM Architektur

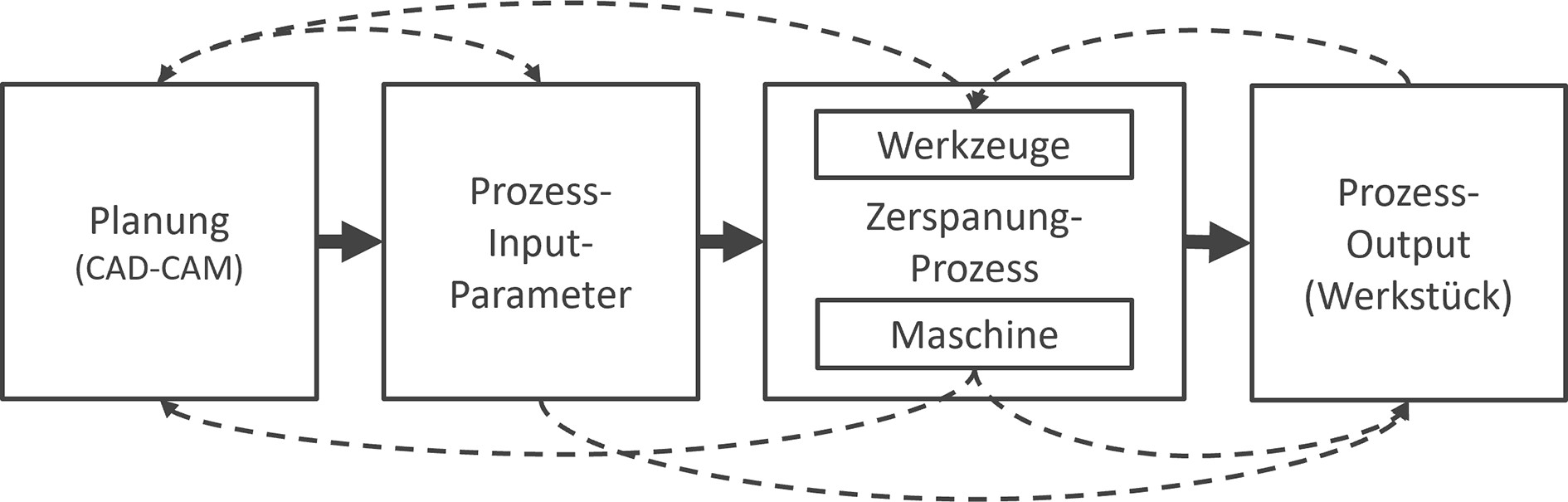

Für den selbstlernenden Ansatz in der Kleinserien-Fertigung sind in der AICoM-Architektur, Bild 2, zwei Regelkreise entworfen worden. Der innere Echtzeitnahe-Regelkreis (Neartime) und der äußere Regelkreis (Erfahrungsregelkreis). Im Neartime-Regelkreis werden Daten während des Prozesses akquiriert, verarbeitet und für das Prozess-Monitoring und die Prozess-Optimierung genutzt. Der Erfahrungs-Regelkreis ist notwendig, um alle Informationen und Erfahrungen von vielen Werkstücken für die Planung, NC-Programmerstellung, Werkzeuge und die Produktionsprozesse zu sammeln und bereitzustellen. Diese sind die Basis, um daraus zu lernen und das neue Wissen beim nächsten Werkstück einfließen zu lassen. Ein wichtiger Baustein ist der dafür notwendige Wissensspeicher. Die Architektur ist in [1] detailliert beschrieben.

![Bild 2. AICoM Architektur – mit einem inneren und äußeren Regelkreis. Grafik: PTW, Uni Darmstadt [1]](https://www.ingenieur.de/wp-content/uploads/2024/04/W_BMBF_Projekt-AIC_Bild-2.jpg)

Bild 2. AICoM Architektur – mit einem inneren und äußeren Regelkreis. Grafik: PTW, Uni Darmstadt [1]

2 Die Rolle der Daten

Daten sind der zentrale Erfolgsfaktor für KI-basierte Projekte. Dabei gilt: Je besser die Daten die Realität abbilden, desto besser funktioniert die KI. Ein einfaches Beispiel: Wenn KI für einen Bäcker die Backwaren prognostizieren soll, damit er nicht zu wenig und nicht zu viele Backwaren hat, dann reicht es nicht, nur die Daten der Kassenbons der letzten drei Jahre zu verwenden. Wetter, Ferienzeiten, Wochentag, Veranstaltungen, Lage oder Bevölkerungsstruktur beeinflussen den Warenumschlag beim Bäcker.

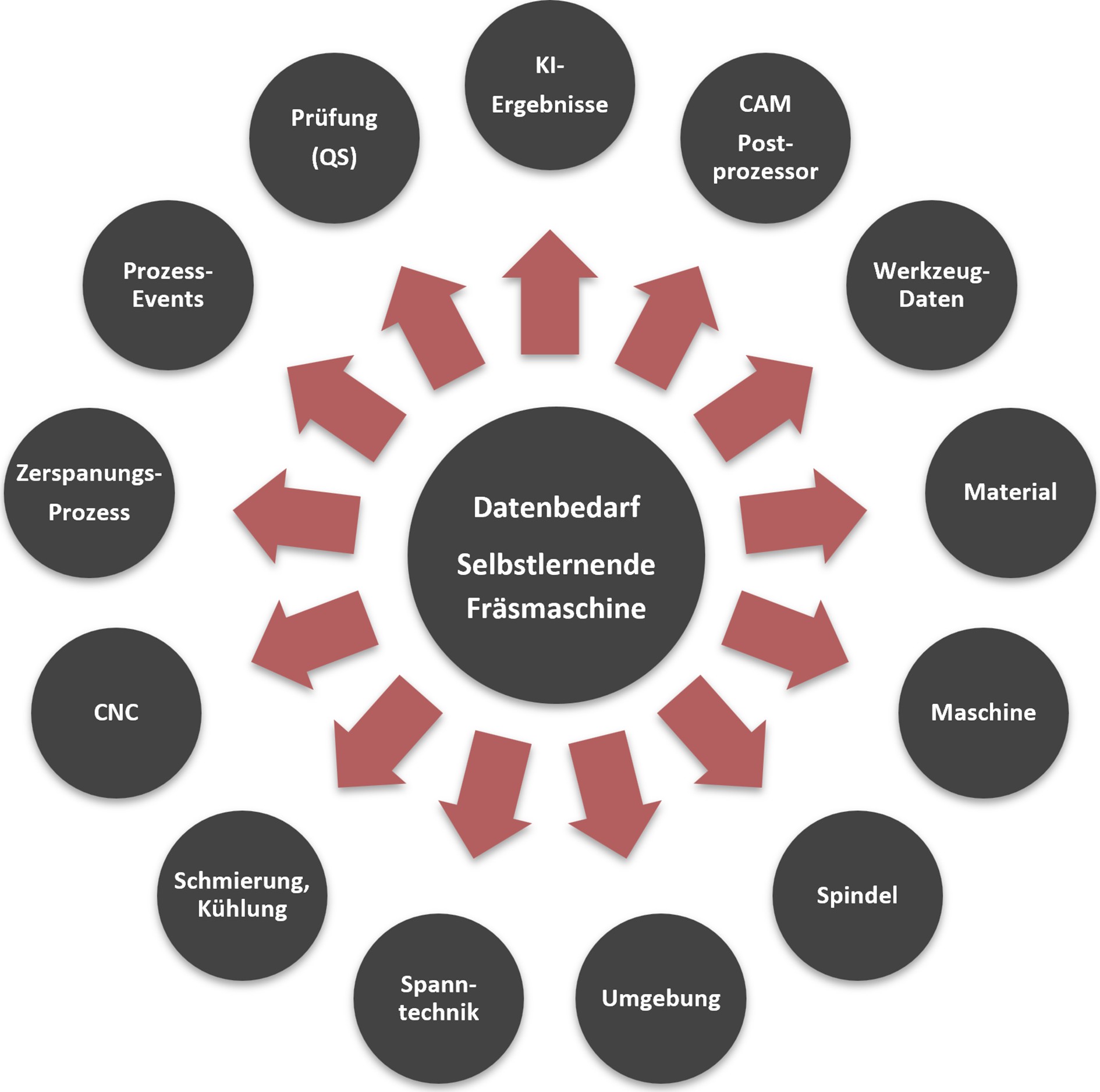

Um dem Ziel der autonomen (selbstlernenden) Fräsmaschine für die Kleinserienfertigung näher zu kommen, werden vollständige Daten über alle Prozessschritte, Objekte, Einflussfaktoren, Ereignisse und Prozessergebnisse benötigt, Bild 3. Nur dann kann die KI daraus lernen und den manuellen Expertenaufwand sukzessive reduzieren.

2.1 Wechselwirkungen mit Daten erfassen

Dabei spielt die Zusammenarbeit zwischen CAM-Software und der Werkzeugmaschine eine entscheidende Rolle, indem sie es ermöglicht, komplexe Produktionsaufgaben und Werkzeugbahnen digital zu planen und zu simulieren. Die CAM-Software wird verwendet, um NC-Programme zu erstellen, die an die CNC-Maschinen übermittelt werden. Diese NC-Programme enthalten präzise Angaben zu Bewegungen, Geschwindigkeiten, Drehzahlen, Werkzeugwechseln und anderen Parametern, die für die Herstellung des Werkstücks notwendig sind. Diese sogenannte Bahnplanung der Maschine, die bestimmt welches Werkzeug wie viel Rohmaterial zerspant, ist ein entscheidendes Kriterium der Wirtschaftlichkeit.

Bild 4. Wechselwirkungen sind in allen Phasen der Metallverarbeitung vorhanden. Grafik: Synop Systems

Ein weiterer wichtiger Aspekt ist die Interaktion zwischen Werkzeug und Werkstück. Da das Zerspanungswerkzeug mit seiner Schneide in das Rohmaterial eindringt und einen Span abhebt entstehen hierbei Kräfte, Wärme und Verschleiß. Die Zerspanungsparameter haben einen entscheidenden Einfluss auf diese Punkte und müssen deshalb optimiert werden. Diese Zerspanungsparameter sind aber pro Werkzeug und Geometrieform sehr unterschiedlich, denn ein Fräser wird für Taschen, Nuten und Bohrungen eingesetzt, und pro Werkstück sind die Geometrieformen sehr unterschiedlich. So entsteht eine sehr hohe Varianz in den Zerspanungsparametern.

2.2 Datenbedeutung und Datenqualität

Die Überprüfung des verfügbaren Datenraums erfolgte im AICoM-Projekt in der allerersten Phase. Lücken oder Mängel in der Datenqualität konnten in der Folge behoben werden. Für datenbasierte Lösungen aller Art, insbesondere aber für Projekte mit vielen dynamischen Daten, ist es grundsätzlich wichtig, die Daten nach den Kriterien Vollständigkeit, Redundanzfreiheit, Eindeutigkeit, Konsistenz, Relevanz, Aktualität, Zuverlässigkeit, Einheitlichkeit und Genauigkeit zu prüfen. Zusätzlich muss die Verknüpfbarkeit der Datenmerkmale zwischen allen Objekten und Prozessen gegeben sein. Für Werkzeuge lässt sich diese Bedingung kaum umsetzen. Denn hierzu müsst jedes Werkzeug mit einer eindeutigen Kennung versehen sein, um es jedem Prozess zuordnen zu können.

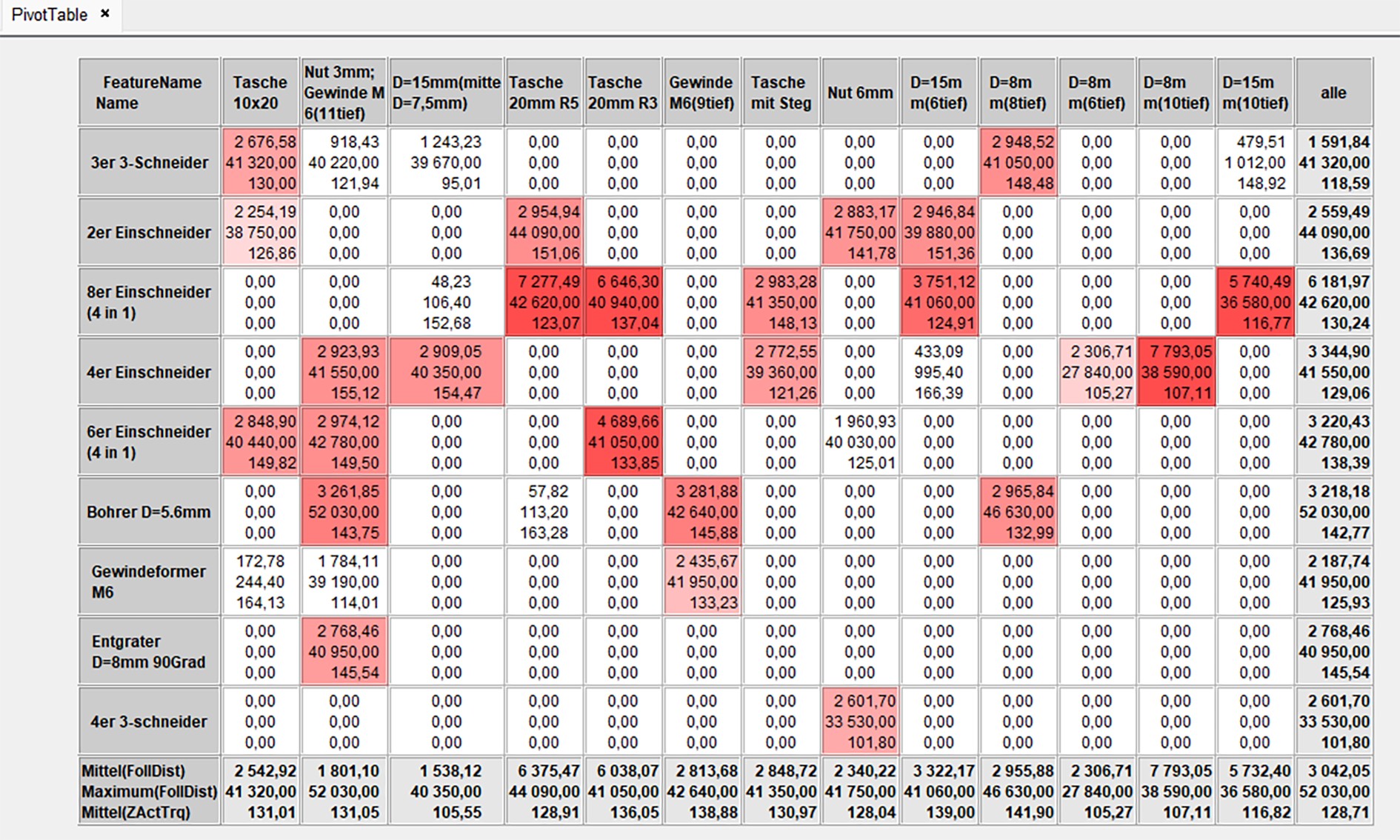

Ein weiterer Aspekt ist die Unterscheidung der Daten in die Kategorien Zielwerte, Sollwerte, Istwerte bzw. resultierende Werte. Dies ist wichtig für das Prozessverständnis und insbesondere für die Entwicklung von Prognosemodellen. Sollwerte sind z. B. die Achspositionen, die nach der Nullpunkterfassung für eine Bearbeitung angefahren werden sollen. Istwerte sind dann die tatsächlichen Achspositionen, die durch Regelung erreicht werden. Die Datron CNC-Steuerung liefert Sollwerte (Commanded), den erreichten Istwert (actual) sowie die Abweichungen (Following Error) für alle Achsen, Antriebe, Spindel und deren Stellgrößen wie z. B. Drehzahl, Strom und Beschleunigung. Die interne Regelung einer WZM versucht die Sollwerte so genau wie möglich zu erreichen. Im AICoM-Projekt wurde ein Use-Case (siehe Kap. 2.3) umgesetzt, der kritische Abweichungen erkennt und versucht, diese mithilfe von KI zu optimieren. In der allerersten Phase eines KI-Projektes ist es wichtig, die Rohdaten mit einfachen Statistikmethoden (Korrelation, multivariate Analysen, Split-Tests) bezüglich Redundanzen, Korrelationen und Kausalitäten zu qualifizieren. In Bild 5 wird mit einer Pivot-Tabelle beispielhaft der Zusammenhang zwischen Mittelwert der Abweichungen (Wert 1. Zeile), Werkzeug und Feature visualisiert. Der Wert in der 2. Zeile entspricht dem maximalen FollDist.-Wert, die 3. Zeile dem Mittelwert des Drehmoments der Z-Achse (Datenbasis Versuchsteilproduktion).

Bild 5. Pivot-Tabelle zeigt den Zusammenhang zwischen Werkzeug, Feature und Soll-/Ist-Abweichung: Grafik Synop Systems

Es wurden ca. 80 Maschinenmerkmale ausgewählt. Die CNC-Steuerung (TWINCAT) überträgt diese Daten an einen Edge-Industrie-PC (IPC), wo sie auch zwischengespeichert werden.

2.3 Das virtuelle Werkstück (Digitaler Zwilling)

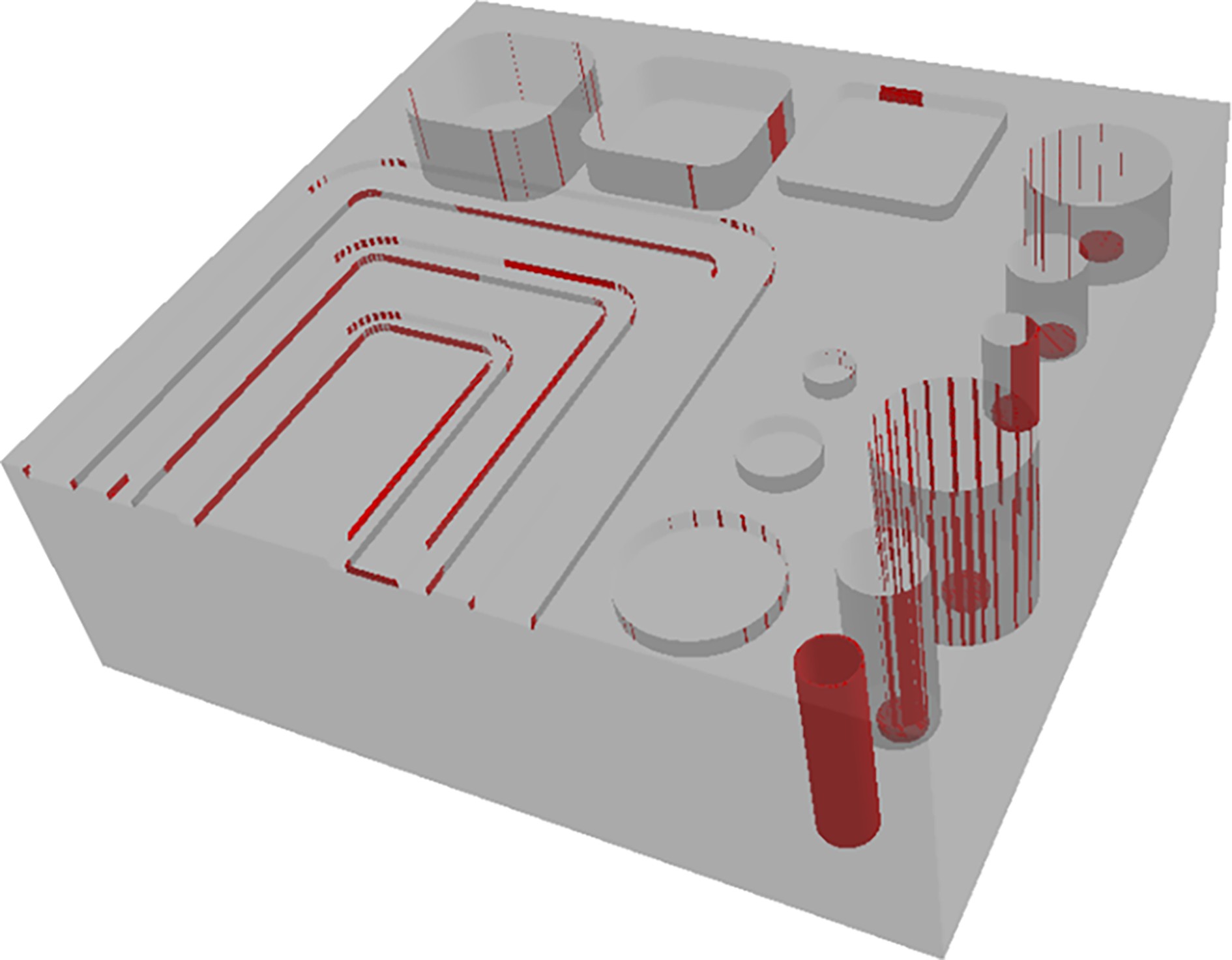

Mit den oben genannten Datenpunkten ist es möglich, die geplante Soll-Geometrie (3D-Bauteil) exakt abzubilden. Dabei spielen die Maschinendynamik sowie die Maschinenmassen eine große Rolle. Die Massen der bewegten Teile einer Maschine können insbesondere bei hohen Geschwindigkeiten und Beschleunigungen zu Trägheitseffekten führen. Dies kann zu Schwingungen und damit zu Abweichungen von der Soll-Geometrie führen. Dieser Effekt wird besonders verstärkt, wenn die z. B. durch die Bearbeitung eingebrachten Schwingungen die Resonanzfrequenzen der Maschine treffen. Durch Simulationen in der virtuellen Maschine, unterstützt durch hochfrequente Datenerfassung, konnten Abweichungen des Ist-Prozesses von der Soll-Geometrie nachgewiesen werden. Diese können nun in weiteren Iterationsschritten optimiert werden. In Bild 6 werden mit den roten Linien die Abweichungen zwischen der Soll-Geometrie und der produzierten Geometrie visualisiert. Dies ist die Grundlage für die KI-unterstützte Planungsphase, welche im äußeren Regelkreis (Kap. 4.1) implementiert wurde.

Bild 6. Das virtuelle Werkstück mit markierten Abweichungen von der Soll-Geometrie. Grafik: PTW, Uni Darmstadt

2.4 Optimierungsbedarf identifizieren

Das AICoM-Projekt hat einen starken Praxisbezug. Die Versuche werden direkt beim Projektpartner Lorenz Hoffmann durchgeführt. Dadurch fließen die realen Probleme eines Einzelfertigers in das Projekt ein und die Praxistauglichkeit wird direkt beim Anwender validiert. Bei der Prozessanalyse und Datenerfassung wurden kleine Lücken identifiziert. Prozessereignisse wie Spannnester, Rauchentwicklung oder Geräusche werden nicht immer vollständig erfasst und können nicht immer zugeordnet werden. Da fast alle Werkstücke aus Aluminiumblöcken gefertigt werden, sind die Werkzeugstandzeiten sehr hoch. Die Werkzeuge werden aber für viele verschiedene Geometrien mit unterschiedlichen Schnittwerten in unterschiedlichen Werkstücken eingesetzt. Werkzeugwechsel werden von den Bedienern auf Basis von Erfahrungswerten und Sichtprüfungen durchgeführt. Für KI-gestützte Entscheidungen sind Prozessereignisse und Werkzeugwechsel aber wichtige Informationen, die zu erfassen sind. Erheblicher Aufwand entsteht auch durch manuelle Erstellungen von Prüfplänen und deren analoge Erfassung. Diese Aspekte sind in den AICoM-Anforderungen berücksichtigt worden.

3 Der Wissensspeicher

Was im Handel, bei Banken und im E-Commerce längst üblich ist, ist auch für die selbstlernende Werkzeugmaschine notwendig: eine analytische Datenhaltung mit einer 360°-Sicht auf alle Phasen. In der IT wird dies als Data Warehouse (DWH) oder Data Lake bezeichnet. In einem DWH werden Daten aus mehreren operativen Systemen in einer relationalen Datenbank zusammengeführt. Komplexe Abfragen, wie Korrelationsanalysen, Key-Performance-Indicator-Berechnungen (KPI) und maschinelle Lernverfahren (ML) können durchgeführt werden, ohne die transaktionalen Prozesse zu belasten. Bei einem DWH legt ein Datenschema fest, welche Daten in welcher Struktur, Auflösung und mit welchem Verknüpfungsschlüssel eingelesen werden. Ein Data Lake hingegen stellt einen großen Pool von Rohdaten dar, für den die Verwendung noch nicht festgelegt ist.

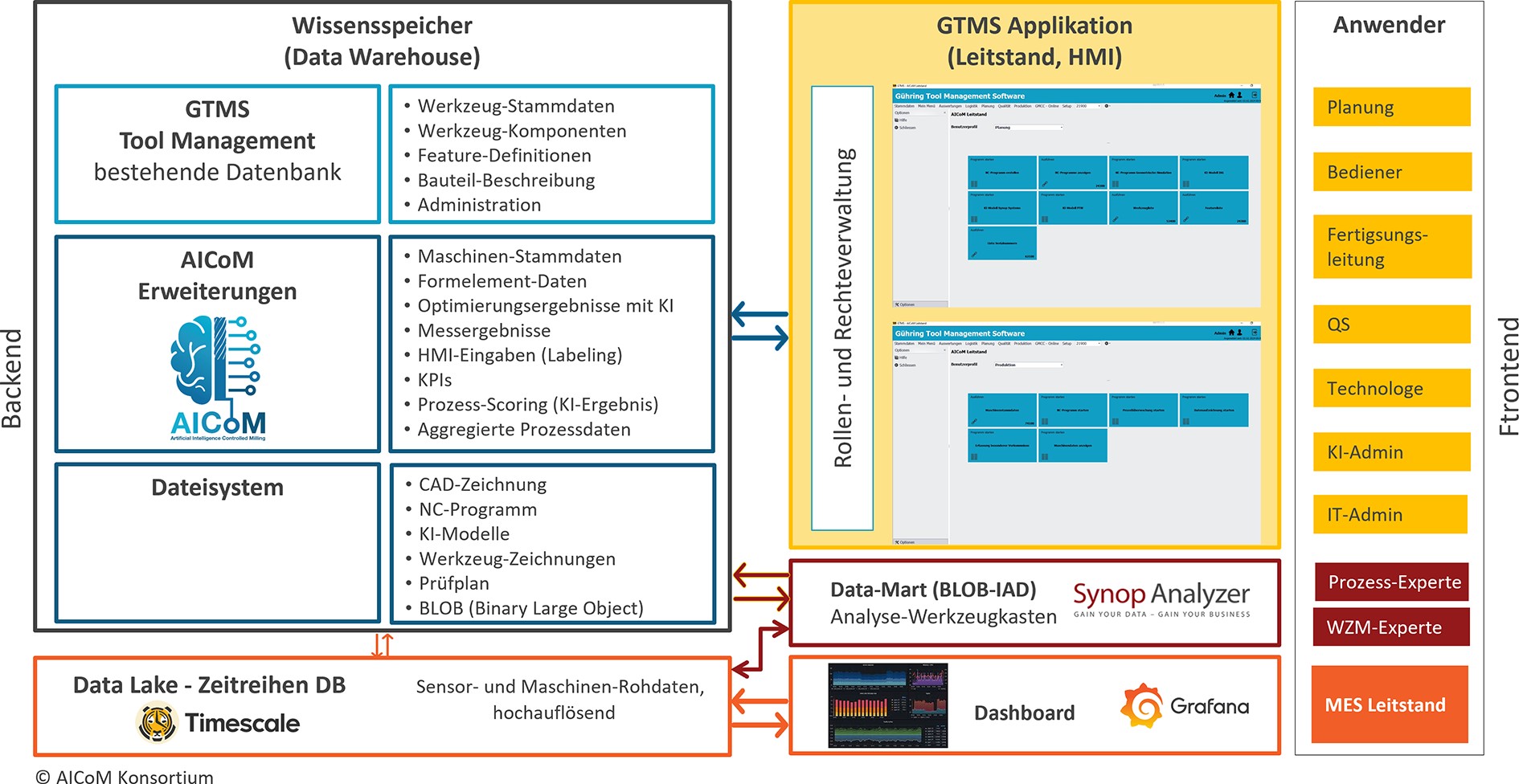

Für den Anspruch des AICoM-Projekts mit einem selbstlernenden WZM ist es besonders wichtig, dass alle Informationen zu jeder Phase der Produktentstehung persistent zur Verfügung stehen. Aus diesem Grund wurde im AICoM Projekt eine ähnliche Architektur, Bild 7, entwickelt. Der AICoM Wissensspeicher stellt eine 360°-Sicht auf alle verfügbaren Daten des Gesamtprozesses dar. Der Wissensspeicher entspricht quasi einem DWH, wobei die Basis die bestehende Datenbank des Gührung Tool Management Systems (GTMS) ist. Diese Datenhaltung ist jedoch nicht für hochfrequente Daten geeignet. Die DATRON CNC-Steuerung liefert einen Datenfeed in schneller Folge mit vielen hochfrequenten Informationen. Hierfür wird die leistungsfähige Zeitreihen-Datenbank Timescale eingesetzt.

Die Auswahl der Daten, die Art der Speicherung und das Zugriffsmanagement wurden im Konsortium abgestimmt. Die durch die beiden Regelkreise generierten Informationen erweitern sukzessive das Wissen. Für den gesamten Planungs- und Produktionsprozess steht ein einheitliches Frontend mit unterschiedlichen Rollenkonzepten zur Verfügung. Der Bediener kann Prozessereignisse über ein HMI (Human Machine Interface) direkt neben dem WZM erfassen. Gleichzeitig werden KPIs zur Entscheidungsunterstützung während der Produktion angezeigt.

Ein weiterer Baustein in der Datenarchitektur ist ein Analyse-Werkzeugkasten. Dieser hat die Besonderheit, dass Datenanalysen auf sehr großen Datenmengen von Domain-Experten interaktiv ausgeführt werden können. Über ein definiertes Datenanalyseprojekt werden Daten aus dem Data Lake als auch aus dem Wissensspeicher (DWH) in einen sogenannten Data-Mart zusammengeführt. Ein spezielles Binary-Large-Object (BLOB) File komprimiert diese Daten auf die Größe eines Zip-Files im Batchmodus und speichert dieses File im Dateiverzeichnis des DWHs. Für Versuchsreihenauswertungen, Fehlerursachenanalysen oder das Feature-Engineering (Auswahl der Prädiktoren für Prognosemodelle) wird das BLOB File mit einem Klick in das Data-Mining Tool Synop Analyzer geladen und die Analyse kann beginnen.

3.1 Formelement-zentrische Datenmodellierung

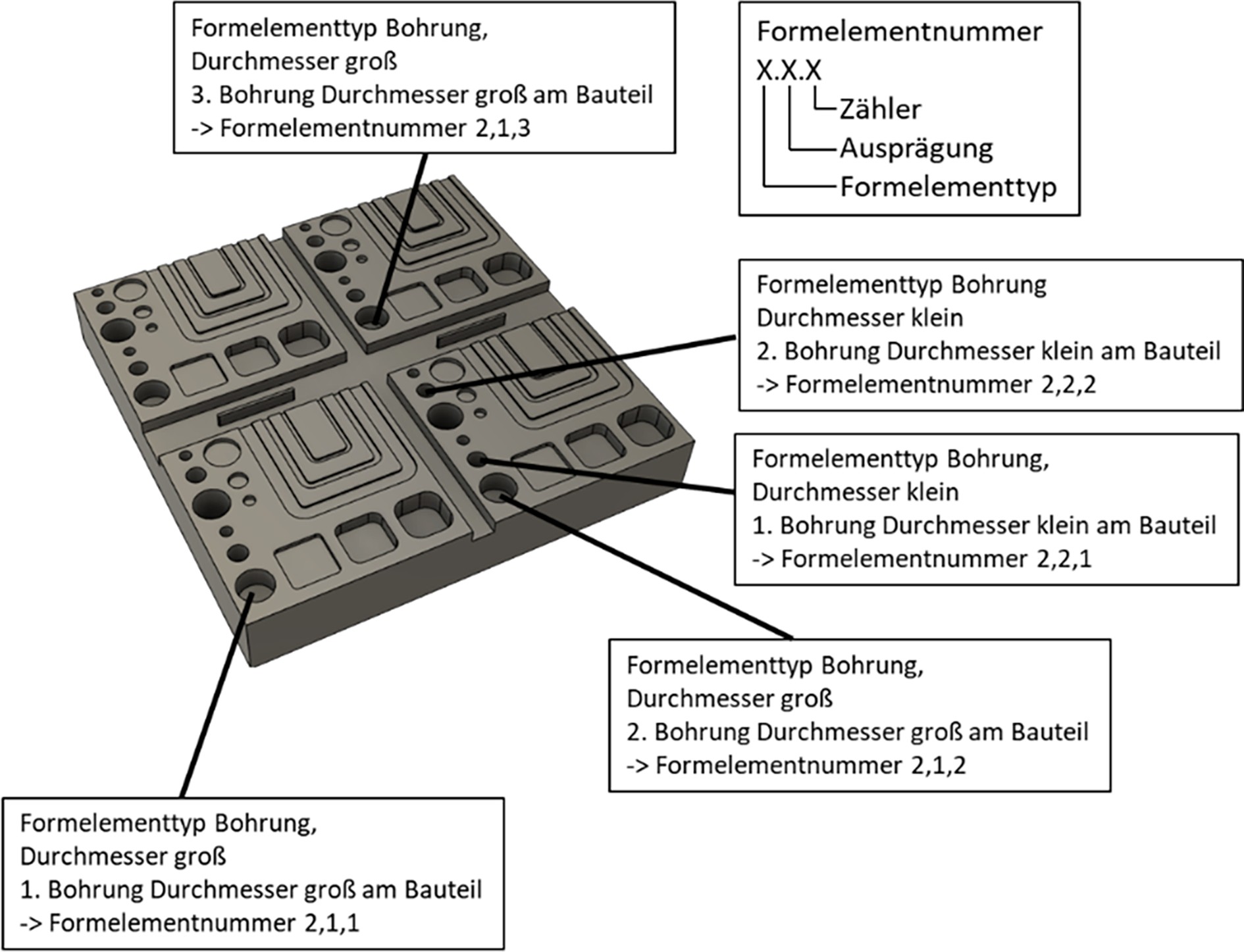

Die Konstruktion eines Werkstücks besteht vereinfacht immer aus einer Kombination von Geometrienformen, die abgetragen werden. Sind diese Formen maßhaltig, ist das Bauteil in Ordnung. Um die AICoM Ziele zu erreichen, muss also der Herstellungsprozess jeden einzelner Form optimiert und fehlerfrei sein. Die Partner des AICoM Projekts verwenden den Begriff Formelement (FE) und beschränken sich auf Typen Tasche, Bohrung, Ebene, Nut und Gewinde.

Während des Fertigungsprozesses muss jedes geometrische Formelement eindeutig identifiziert, Bild 8, werden, um alle gesammelten Daten zuzuordnen. Das erzeugte Prozesswissen muss auf das jeweilige Formelement bezogen gespeichert werden. Bei der Erstellung von NC-Programmen muss das CAD/CAM-System jedem Formelement eine spezifische Nummer zuweisen. Das bedeutet, dass die Datenmodellierung im Wissensspeicher so gestaltet sein muss, dass die besprochenen Daten entsprechend dem geometrischen Formelemente gespeichert und zugeordnet werden können.

Modul Works, AICoM Kooperationspartner, stellt mit dem Next Generation Shop Floor (NGSP) System das CAM-Kernmodul der AICOM-Lösung bereit, welches das NC-Programm, auf Basis der Werkstückgeometriedaten, erstellt. Dabei wird das Prozesswissen berücksichtigt. Im NGSP sind geometrische Formelemente (Feature) definiert, anhand derer die Bahnplanung erfolgt. Für die Erstellung von NC-Programmen müssen Werkzeug- und Wissensdaten in formelementbasierter Weise zur Verfügung stehen.

4 AICoM Regelkreise

Wie eingangs erwähnt sind in der Architektur zwei Regelkriese definiert und umgesetzt werden. Pro Regelkreis können mehre Use-Cases gleichzeitig ausgeführt werden. Eine Erläuterung aller Use-Cases sprengt den Rahmen dieser Publikation. Pro Regelkreis wird im Folgenden jeweils ein KI-basierende Use-Case erläutert.

4.1 KI-Anwendung – äußerer Regelkreis

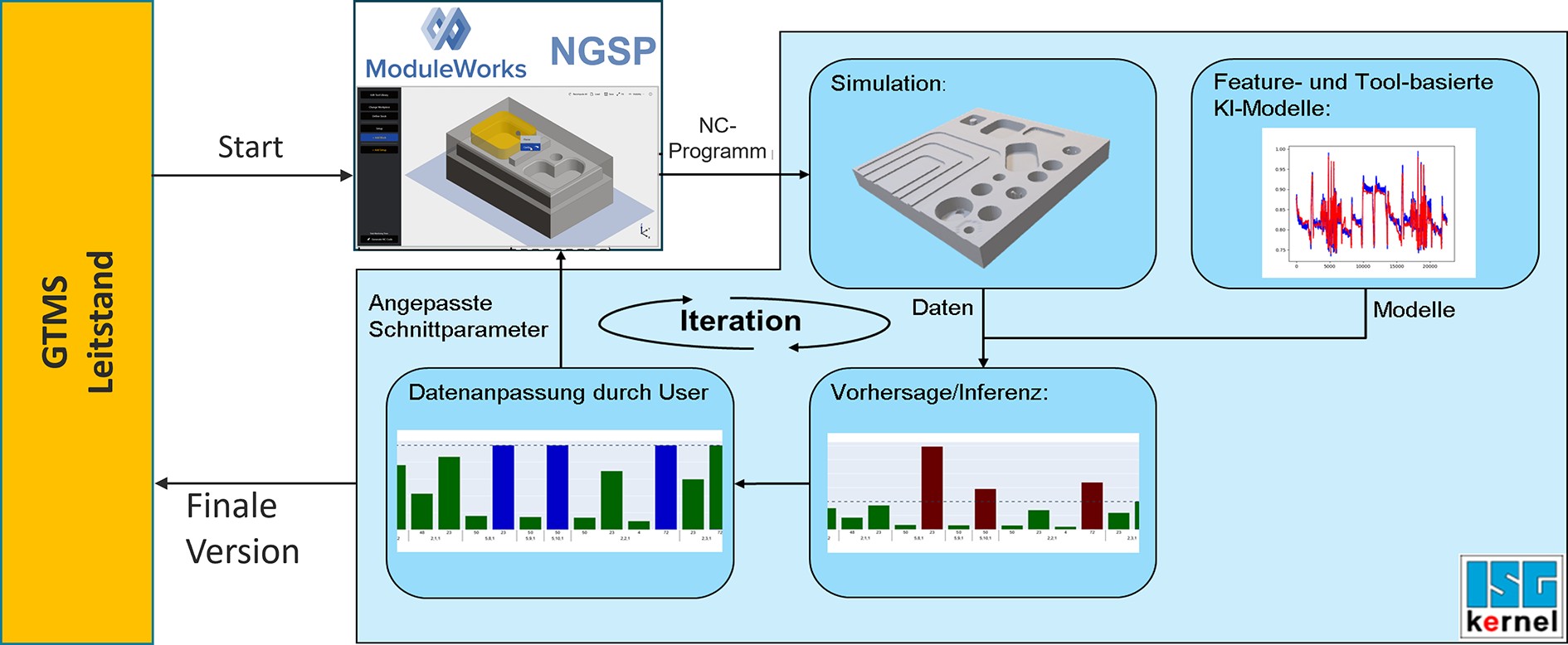

Im äußeren Regelkreis (Bild 2) findet die Planung, Simulation, Erfassung der Prozessergebnisse und die Gewinnung des Erfahrungsschatzes statt. An dieser Stelle wird sehr kompakt der Simulations-Regelkreis erläutert.

Das Ziel dieses Use-Cases ist die Optimierung des NC-Programm bezüglich Maßhaltigkeit, Strategie und Performance. Die NC-Programmerstellung erfolgt im NGSP. Dazu lädt das NGSP die STEP-Datei mit den Bauteildaten und die Werkzeugdaten aus dem GTMS. Die Schnittwerte für die Werkzeuge sind Standardwerte, entweder Katalogwerte der Werkzeughersteller oder Erfahrungswerte des Anwenders. Das NC-Programm durchläuft die Simulation (VCNK – Virtual NC-Kernel) und die resultierenden Ströme für Spindel und Achsen werden von der KI ermittelt. Diese Ströme werden bewertet. Sind sie zu hoch oder zu niedrig, werden die entsprechenden Schnittwerte angepasst. Das KI-System startet NGSP direkt mit den optimierten Schnittwerten und NGSP passt das NC-Programm entsprechend an (Bild 9). Das geänderte NC-Programm wird erneut von der KI bewertet. Diese Optimierungsschleife wird so lange durchlaufen, bis die KI keine Schnittwertoptimierung mehr ermitteln kann. Abschließend zeigt das AICoM-System diese Werte dem Benutzer an, der sie entweder akzeptiert oder verwirft.

4.2 KI-Anwendung – innerer Regelkreis

Die Vorhersage des optimalen Zeitpunkts für den Austausch von Werkzeugen, die Identifikation eines potenziellen Bruchs, die plötzliche Entstehung eines Spannestes oder einer Aufbauschneide stellt in Zerspanungsprozessen nach wie vor eine signifikante Schwierigkeit dar. Diese Probleme führen oft zu nicht eingeplanten Pausen im Produktionsablauf und einem Anstieg der fehlerhaften Produkte. Dank der zunehmend präziseren Bereitstellung hochfrequenter Daten durch die Steuerungssysteme von Werkzeugmaschinen, stellt diese Fähigkeit einen Schlüsselfaktor für den Erfolg KI-basierten Innovation in der Fertigungsindustrie dar. Diese Fähigkeit wird im inneren AICoM Regelkreis von zwei KI-Anwendungen genutzt. Im nachfolgenden wird, das von Synop Systems entwickelte Prozess-Stabilitäts-Monitoring erläutert.

4.2.1 Neartime Prozess-Stabilitäts-Scoring (NT-PSS)

Der Prozess-Scoring Algorithmus (Bild 10) erhält den Zerspanungs-Datenausschnitt eines Formelements und bewertet das Signalverhalten mit einem sogenannten Prozess-Stabilitäts-Score (0,0 bis 1,0). Ein hoher Score-Wert bedeutet, dass der Prozess einer wiederkehrenden Bearbeitung stabil ist. In umfangreichen Vortests konnte der Algorithmus nachweisen, dass Veränderungen in den Signalen (z. B. Drehmoment, Strom), hervorgerufen durch Verschleiß, Prozessprobleme oder Werkzeugbruch, richtig erkannt wurden. Dies bedeutet nicht, dass das Verfahren die Ursache (z. B. Verschleiß, schlechte Kühlung) benennen kann, sondern feststellt, dass in einem aktuellen Prozess eine Abweichung vom „Gut-Verhalten“ aufgetaucht ist. Um die Latenzen klein zu halten, erfolgt die Ausführung des KI-Algorithmus direkt auf dem Edge IPC. Das NT-PSS Verfahren ist selbstlernend und benötigt keine Trainingsdaten, so dass es sich besonders für die Produktion von Kleinserien eignet. Der Score-Werte eines FE und die zugehörigen FE-Informationen werden dem Bediener angezeigt. Mit weiteren Angaben (Ursache, Problem), auch Labeling genannt, wird Kontextwissen aufgebaut. Durch wiederholtes Labeling kann das System zunehmend die Ursache für das Problem direkt benennen und Empfehlungen für eine Handlungsmaßnahme anzeigen.

Signalverläufe und deren Score-Werte identischer Formelemente werden im Wissensspeicher gespeichert und für die Prognose der nächsten Bewertung herangezogen. Anwendungen des Verfahrens umfassen unter anderem die Vorhersage von Qualität, Werkzeugverschleiß und Werkzeugbruch.

5 Zusammenfassung und Ausblick

Ausgehend von der ersten Projektskizze (Architektur) hat das Konsortium viele lauffähige Bausteine erarbeitet und erfolgreich zusammengefügt. Der Aufbau des Wissensspeichers mit Schnittstellen zu allen beteiligten Systemen, die notwendige Datenmodellierung und Datenintegration sind elementare Module auf dem Weg zur autonomen WZM. Die sehr hohe Datenverfügbarkeit ermöglicht weitere datengetriebene Anwendungen wie Schleppfehler- und Reibungskompensation. Eine große Herausforderung ist die Generierung von Versuchsreihendaten mit „gewünschten“ Prozessproblemen, die die Grundlage für das Training und die Validierung von maschinellen Lernverfahren (ML) bilden. In der Aluminiumverarbeitung stellt dies eine besondere Herausforderung dar. Das ebenfalls am Projekt beteiligte Institut für Datenmanagement, Prof. Bining, der TU Darmstadt könnte die Versuchsplanung bald vereinfachen. Ein vielversprechender Algorithmus zur Datenanreicherung (Augmentation) soll es ermöglichen, aus einer begrenzten Menge von Prozessdaten eine umfangreiche Datenbasis zu generieren.

Der AICoM-Demonstrator ermöglicht über einen Leitstand alle Prozessschritte vom Einlesen der Step-Datei über das Einspielen eines optimierten NC-Programms in die CNC-Maschine bis hin zur Überwachung des laufenden Bearbeitungsprozesses. Wie nahe das AICoM-Projekt der 4. Stufe einer autonomen Werkzeugmaschine kommt, wird der tatsächlich anfallende manuelle Aufwand zeigen.

Dieses Forschungs- und Entwicklungsprojekt wird durch das Bundesministerium für Bildung und Forschung (BMBF) im Programm „Zukunft der Wertschöpfung – Forschung zu Produktion, Dienstleistung und Arbeit“ (Förderkennzeichen 02P0A060 bis 02P0A065) gefördert und vom Projektträger Karlsruhe (PTKA) betreut. Die Verantwortung für den Inhalt dieser Veröffentlichung liegt bei den Autoren.

Literatur

- Sarikaya, E.: Selbstlernende Werkzeugmaschine für die Einzelstückfertigung, 2023

- Dittrich, M.-A.: Autonome Werkzeugmaschinen – Definition, Elemente und technische Integration, Tewiss Verlag, 2021.

- Sarikaya, A. D. E.: AICom – Die selbstlernende Werkzeugmaschine von morgen, Würzburg, 2023

Dipl. Ing. (FH) Volker Marquardt Foto: Autor

Synop Systems UG (haftungsbeschränkt)

Tel. + 49 721 / 94538-11

marquardt@synop-systems.com

www.synop-systems.com

Dipl. Ing. (FH) Andreas Hoffmann

Foto: Autor

Lorenz Hoffmann GmbH

Tel. +49 7957 / 92493-0

andreas.hoffmann@hoffmanngmbh.com

www.hoffmanngmbh.com