KI in den Standard überführen

Daten-Aufbereitung für KI-Anwendungen ist bisher noch relativ aufwendig. Die richtige Datenablage vereinfacht die Anwendung von KI-Software deutlich.

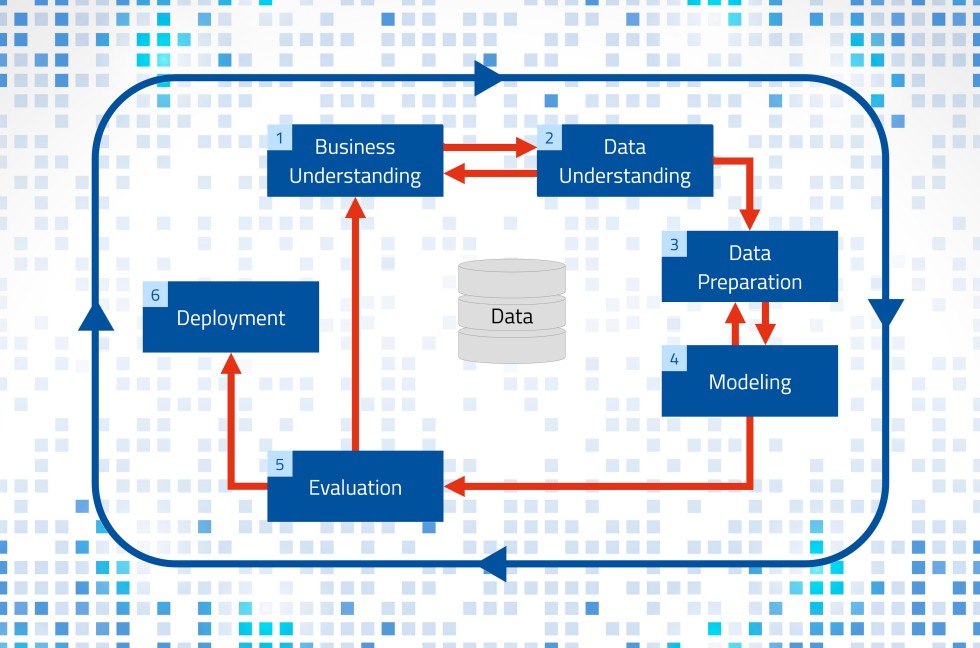

Cross Industry Standard für Data Mining (CRIPS-DM) - angelehnt an Wikipedia. Grafik: MPDV, Adobe Stock, Rawpixel.com

Sowohl im Alltag als auch in der Smart Factory mehren sich die Anwendungsfälle für Künstliche Intelligenz (KI). Allerdings scheuen sich gerade kleine und mittelständische Unternehmen, KI einzusetzen, da dies bisher mit erheblichem Aufwand und mit hohen Kosten verbunden war. Denn Künstliche Intelligenz gab es bislang nur als individuelles Projekt. Um Kosten und Aufwand im Rahmen zu halten, braucht es aber eine „out of the box“-Lösung, also eine Standardlösung, die möglichst sofort einsatzbereit ist.

Der Traum, dass eine Maschine intelligente Entscheidungen trifft, existiert schon länger als es Computer im heutigen Sinne gibt. Erste Ansätze, die sich mit der heutigen Technik vergleichen lassen, stammen aus den 1950er-Jahren. Einen wahren Boom erlebt KI jedoch erst seit einigen Jahren, weil die Computer nun leistungsstark genug sind und sukzessive auch die Akzeptanz für den Einsatz von KI gestiegen ist. Den jüngsten Hype erleben wir aktuell mit ChatGPT und ähnlichen oder darauf basierenden Angeboten. Der Weg, Künstliche Intelligenz als Standardprodukt in der Smart Factory zu nutzen, scheint aber noch weit zu sein.

Der lange Weg zur KI-Lösung

Warum kann man Künstliche Intelligenz nicht einfach zuschalten wie den LED-Blitz am Handy, der zumindest im näheren Umfeld eine bessere Belichtung verspricht? Ein Blick „hinter die Kulissen“ sorgt für Klarheit: Im Jahr 1996 wurde ein branchenübergreifendes Standardvorgehen für den Umgang mit großen Datenmengen entwickelt, das auch heute noch in KI-Projekten genutzt wird – Cross Industry Standard for Data Mining (CRISP-DM). Darin ist anwendungsneutral beschrieben, was getan werden muss, bevor man aus großen Datenmengen einen Nutzen ziehen kann. Dabei sind sechs Phasen zu durchlaufen, die sich teilweise überlappen oder bedingen:

- 1. Geschäftsverständnis (Business Understanding)

- 2. Datenverständnis (Data Understanding)

- 3. Datenvorbereitung (Data Preparation)

- 4. Modellierung (Modeling)

- 5. Evaluierung (Evaluation)

- 6. Bereitstellung (Deployment)

Insbesondere die Phasen vor der Modellierung – also das Aufbereiten der Daten – nehmen einen großen Teil der Zeit und der Kosten in typischen KI-Projekten ein. Und diesen meist manuellen Aufwand muss ein Data Scientist für jedes Projekt von Neuem betreiben. Ist ein KI-Modell fertig, so kann es ausgerollt und solange genutzt werden, bis sich die Rahmenbedingungen so weit geändert haben, dass das Modell überarbeitet oder erweitert werden muss. Denn wie von ChatGPT bekannt ist, lernt ein KI-System nicht per se kontinuierlich dazu. Ideal und kostensparend wäre es, wenn man sowohl das Erstellen als auch das Erweitern von KI-Modellen ganz einfach automatisieren könnte – also quasi Automated Data Science. Man kann die Daten aber auch so zur Verfügung stellen, dass die Phasen eins bis drei überflüssig werden und sofort mit dem Modellieren begonnen werden kann.

KI als Standardlösung

Daten in einer homogenen Form bereitzuhalten, gehört zu den Kernaufgaben der modernen Fertigungs-IT. Die Schlagworte lauten Integrationsplattform und semantisches Datenmodell. Sind also alle Daten in einer gemeinsamen Plattform semantisch abgelegt, so ist es ein Leichtes, dass KI-Software darauf zugreift und diese zur Modellbildung verwendet. Die Manufacturing Integration Platform (MIP) von MPDV ist eine solche Integrationsplattform, die als gemeinsame Datenbasis genutzt werden kann.

Vergleichbar mit dem Entwickeln browserbasierter Computerspiele kann man immer neue Szenarien aufbauen, die auf den stets gleichen Prinzipien fußen. Um im Bild zu bleiben: Für die dahinterliegende Spiele-Engine ist es nicht relevant, ob man eine Weltraumstation konstruiert und Rohstoffe fremder Planeten abbaut oder einen mittelalterlichen Bauernhof mit angeschlossener Viehzucht betreibt. In beiden Fällen gibt es Wohngebäude, Produktionsstätten, Rohstoffe und eine Art von Währung, mit der man alles handeln kann, was benötigt wird. Die dahinterliegende Datenbasis ist also gleich, es wird lediglich unterschieden, wofür diese Daten verwendet werden.

Zurück zur Fertigungs-IT: Eine Integrationsplattform hält umfangreiche Daten vor, die von unterschiedlichen Anwendungen genutzt und verarbeitet werden. Ob man nun die Nutzgrade einer Maschine analysiert oder vorhersagt, wie lange die Rüstzeit bei einem bestimmten Artikelwechsel sein wird, ist für die Plattform erstmal irrelevant. Die semantische Ablage der Daten stellt sicher, dass jede Anwendung die Daten versteht und für den jeweiligen Zweck nutzen kann. Damit ist der Weg frei für Standardanwendungen.

Auch seitens der KI-Engine ist nicht relevant, wofür die gesammelten Daten genutzt werden. Das Prinzip ist immer gleich:

- 1. Die Software analysiert historische Daten.

- 2. Die KI erkennt Muster und ermittelt Einflussfaktoren.

- 3. Anhand dieser Erkenntnisse kann die KI Zusammenhänge visualisieren. Alternativ kann die KI auf Basis der Erkenntnisse Vorhersagen treffen.

KI in der Smart Factory

Die Feinplanung von Aufträgen, Werkzeugen und Mitarbeitenden ist nur ein Beispiel, in den Künstliche Intelligenz in der Smart Factory für mehr Effizienz und in Summe für mehr Wettbewerbsfähigkeit sorgt. Aufgrund der KI-Unterstützung werden Produktionskosten gesenkt, die Termintreue gesteigert und die vorhandenen Ressourcen optimal eingesetzt. Wenn alle benötigten Daten dafür strukturiert und semantisch geordnet vorliegen, kann eine solche Planungsanwendung Szenarien aller Art planen. Dabei ist unerheblich, ob ein großer Kunststoffhersteller seine 800 Spritzgießmaschinen planen möchte oder ein kleiner Metallverarbeiter zehn Pressen, ein CNC-Bearbeitungszentrum und 20 Handarbeitsplätze.

Gleiches gilt für die KI-basierte Analyse von Ausschuss oder Nutzgraden. Der KI-Algorithmus analysiert die historischen Daten, erkennt Einflussfaktoren und stellt diese in einer Form dar, dass der Benutzer mit seinem Domänenwissen zielführende Schlüsse daraus ziehen kann. Solange die zur Verfügung gestellten Daten alle nach dem gleichen Prinzip aufgebaut sind, kann die KI damit arbeiten und liefert Ergebnisse, die anschließend mit der gleichen „Brille“ betrachtet werden können wie die Eingangsdaten.

Praxisbeispiel: Predictive Quality

Predictive Quality basiert auf der Erfahrung, dass es auch dann zu Ausschuss oder Nacharbeit kommen kann, wenn sich alle Prozessparameter innerhalb der jeweils gültigen Toleranzgrenzen bewegen. Grund dafür sind komplexe Zusammenhänge und Wechselwirkungen, die auf die eigentliche Fertigungstechnologie zurückzuführen sind. In der Praxis werden verschiedene Prozesswerte zusammen mit der Qualitätseinstufung als Basis dafür verwendet, zu entscheiden, mit welcher Wahrscheinlichkeit das aktuell produzierte Produkt ein Gutteil wird oder Ausschuss. Dafür braucht es eine repräsentative Sammlung von Daten. Genauer gesagt ein möglichst breites Feld an Prozessdaten, die sich mit dazu passenden Qualitätsdaten korrelieren lassen. Wichtig ist dabei, dass die erfassten Prozesswerte synchron mit den Qualitätseinstufungen sind. Neben der reinen Masse der erfassten Daten ist auch die Vielfältigkeit entscheidend für die Zuverlässigkeit der späteren Vorhersagen. Einfacher gesagt: Je mehr die einzelnen Prozesswerte sich innerhalb ihrer zulässigen Toleranzen verändern und je mehr Kombinationen unterschiedlicher Extremwerte erfasst werden, desto besser.

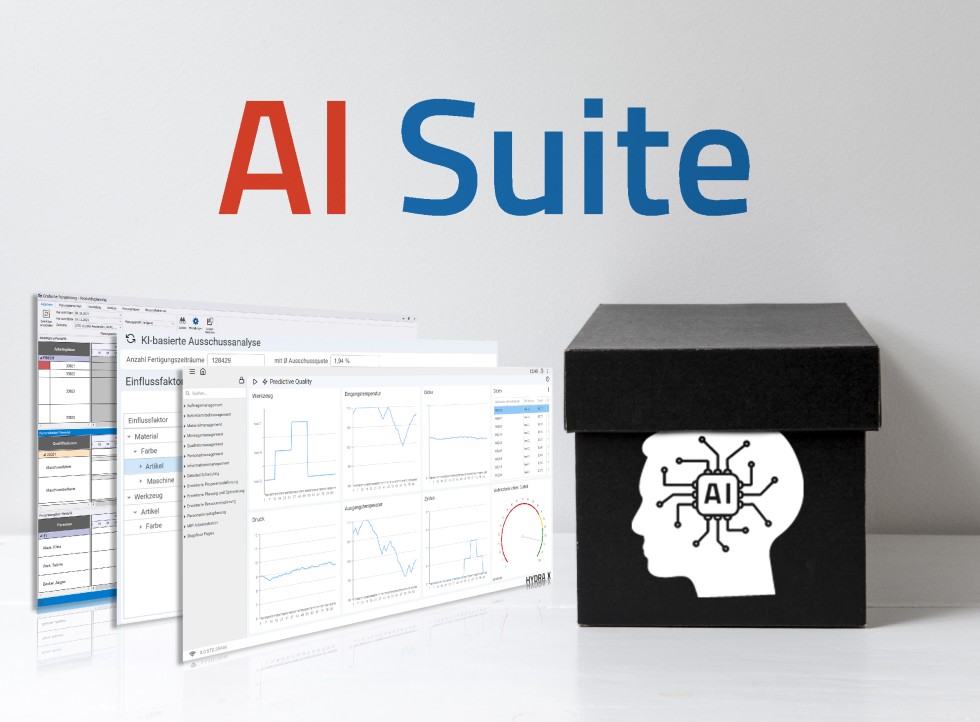

Mit der AI Suite liefert MPDV KI-basierte Standardanwendungen für die Smart Factory.

Foto: MPDV, Adobe Stock, mardek01

Aus der Gesamtheit dieser Daten entwickelt die Künstliche Intelligenz ein Vorhersagemodell, das mit den aktuellen Prozessdaten gefüttert werden kann. Das Ergebnis ist dann einerseits eine Qualitätseinstufung und andererseits eine Wahrscheinlichkeit dafür, dass diese Einstufung richtig ist. Anschließend liegt es in der Verantwortung des Menschen, zu entscheiden, was mit den Ergebnissen gemacht wird. Man könnte zum Beispiel alle Teile, die mit mehr als 60 % Wahrscheinlichkeit Ausschuss sind, sofort recyceln oder explizit prüfen und Teile die zu mehr als 90 % die Einstufung „Gutteil“ bekommen, ungeprüft ausliefern. Je nach Branche und Wertigkeit der hergestellten Artikel könnten die Ergebnisse aus Predictive Quality aber auch ganz anders verwendet werden. Diese Entscheidung kann uns die Künstliche Intelligenz nicht abnehmen – wohl aber die Analyse der Daten und die Vorhersage von Ergebnissen.

Verglichen mit anderen, bekannten Standardanwendungen könnte man sagen: Excel liefert uns Tabellen und bunte Diagramme – egal zu welchem Thema. Was wir auf Basis dieser Daten machen, ist nicht Aufgabe von Excel. Dafür ist es Excel gleichgültig, welche Art von Daten wir damit analysieren und visualisieren – es ist und bleibt eine Standardanwendung. Gleiches gilt für KI-basierte Standardanwendungen.

Standardanwendungen für KI

Es bleibt die Frage zu klären, ob man KI in der Smart Factory einsetzen sollte und wenn ja, wofür. Diese Frage muss jedes Fertigungsunternehmen selbst eruieren und diskutieren. Einen Denkanstoß könnte die neue AI Suite von MPDV liefern. Zur AI Suite gehören aktuell acht Standardanwendungen, die jede für sich gesehen einen Mehrwert bietet und für mehr Wettbewerbsfähigkeit sorgt.

- AI Planning: Produktionskosten senken und Termintreue durch eine optimale Planung steigern.

- AI Workforce Planning: Verfügbare Personalkapazitäten anhand ihrer Qualifikationen optimal einsetzen.

- AI-based Production Time Prediction: Realistische Vorgabewerte ermitteln und damit Planungsergebnisse verbessern.

- AI-based Scrap Analysis: Zusammenhänge, die zu Ausschuss führen, erkennen und verstehen.

- AI-based Capacity Utilization Analysis: Schwankende Nutzgrade einzelner Maschinen erklären.

- AI-based Setup Rate Analysis: Einflussfaktoren auf den Rüstgrad einzelner Maschinen ermitteln.

- AI-based Resource Performance Account Analysis: Betriebsmittelkonten gezielt analysieren.

- Predictive Quality: Qualität von Produkten vorhersagen.

Alle diese Anwendungen nutzen Daten aus der Manufacturing Integration Platform (MIP) und können daher ohne großen Zusatzaufwand eingesetzt werden – so einfach wie der LED-Blitz am Handy. Mit etwas Licht sieht die Kamera besser und mit KI kann man mehr aus seinen Fertigungsdaten herausholen.

MPDV Mikrolab GmbH

74821 Mosbach

www.mpdv.com