Sichtprüfungen mit Maschinellem Lernen automatisieren

Die Überprüfung der Qualität von gefertigten Bauteilen ist für alle produzierenden Unternehmen ein unumgänglicher Arbeitsschritt. Der Einsatz menschlicher Arbeitskraft ist hierbei bisher noch absolut üblich. Doch welche Alternativen gibt es, und welche Vorteile bieten sie?

Die automatisierte Qualitätskontrolle von Komponenten mit polierten Oberflächen ist schwierig - in aller Regel wird bisher eine Sichtprüfung durch den Menschen durchgeführt. Für Abhilfe sorgen jetzt bilddatenbasierte Modelle des Maschinellen Lernens sowie ein kollaborativer Roboter.

Foto: IFW

Während bestimmte Eigenschaften eines Produkts, wie etwa die Maßhaltigkeit, bereits vollständig automatisiert überprüft werden können, erfordern geschliffene oder polierte Oberflächen in der Regel weiterhin die Sichtprüfung durch den Menschen, was zu hohen Nebenzeiten führt. In diesem Artikel wird ein Konzept zur automatisierten Sichtprüfung geschliffener Oberflächen vorgestellt. Hierfür wurden bilddatenbasierte Modelle des Maschinellen Lernens sowie ein kollaborativer Roboter eingesetzt.

Warum bringt Maschinelles Lernen Vorteile?

Sichtprüfungen lassen sich durch unterschiedliche Bildverarbeitungstechniken zur visuellen Inspektion von Produkten automatisieren. Dies kann entweder durch den Einsatz vordefinierter Schwellenwerte erfolgen oder durch den Einsatz von Maschinellem Lernen (ML). Vordefinierte RGB-Schwellenwerte eignen sich beispielsweise dazu, die Farbwerte aufgenommener Bilder von gefertigten Bauteilen mit vordefinierten Farbschwellwerten zu vergleichen. Wenn die lokalen Farbwerte innerhalb des Toleranzbereichs liegen, wird es als in Ordnung befunden. Andernfalls wird es als fehlerhaft markiert. Dieser Ansatz ist jedoch auf Bauteile beschränkt, bei denen die Mängel oder Abweichungen durch einfache und vorhersehbare visuelle Merkmale erfasst werden können. Bei komplexeren visuellen Defekten – wie feinen Oberflächenunebenheiten oder geringen Farbabweichungen – ist dieser Ansatz meistens unzureichend.

Der Einsatz ML-basierter Bildverarbeitungsmethoden erlaubt hingegen die Modellierung komplexer Merkmale und somit eine höhere Anpassungsfähigkeit. Durch „Deep-Learning“-Algorithmen kann ein ML-Modell trainiert werden, komplexe Muster und Merkmale in Bilddaten zu erkennen. Dies ermöglicht eine präzisere und robustere Erkennung von Mängeln oder Abweichungen, selbst bei komplexen visuellen Inspektionsaufgaben.

Maschinelles Sehen als Basis für automatisierte Sichtprüfungen

Am Institut für Fertigungstechnik und Werkzeugmaschinen (IFW) Hannover wurde ein System zur Automatisierung von Sichtprüfungen am Beispiel ebener, geschliffener Oberflächen umgesetzt. Das Ziel bestand darin, automatisiert festzustellen, ob eine Oberfläche geschliffen wurde oder ob sie sich noch im Rohzustand befindet. Zusätzlich sollten Beschädigungen auf der Oberfläche erkannt werden können. Dies geschah in Kooperation mit dem Forschungszentrum L3S in Hannover: Dort entwickeln rund 200 Forscher aus verschiedenen relevanten Disziplinen intelligente, verantwortungsvolle und verlässliche Systeme für die digitale Transformation.

Das nun entstandene System basiert auf dem Konzept des Maschinellen Sehens, einem Teilbereich des Maschinellen Lernens. Beim Maschinellen Sehen werden für die Modellierung primär Künstliche Neuronale Netze verwendet. Neuronale Netze bestehen aus Neuronen, die in einer Eingabeschicht, verborgenen Schichten und einer Ausgabeschicht angeordnet werden. Für die Verarbeitung von Bildern haben sich insbesondere „Convolutional Neural Networks“ (CNNs) bewährt. CNNs verfügen zusätzlich über Faltungs- und Pooling-Schichten. In den Faltungsschichten werden Merkmale wie Kanten, Texturen und Formen erkannt. Die Pooling-Schichten verdichten die Informationen in den Bildern und reduzieren so die Datenmenge. Dies ermöglicht den Einsatz von CNNs für verschiedene Aufgaben in der Bildverarbeitung, wie beispielsweise die Klassifizierung oder die Objekterkennung.

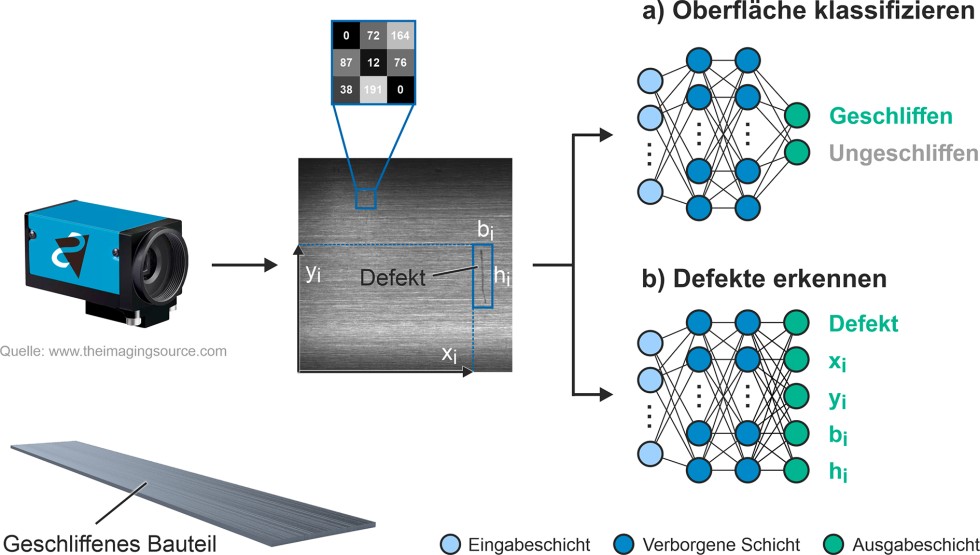

Bild 1. Convolutional Neural Networks (CNNs) können in der Bildverarbeitung unter anderem zur Klassifizierung oder zur Objekterkennung eingesetzt werden. Grafik: IFW

Bild 1 zeigt, wie die Prinzipien der Klassifizierung und der Objekterkennung zur Automatisierung von Sichtprüfungen eingesetzt werden. Mit einer Kamera wird ein Bild von der Bauteiloberfläche aufgenommen (Mitte). Die Grauwerte der einzelnen Pixel des Bildes dienen als Eingabeparameter für zwei verschiedene CNNs (rechts).

Um den Schliffstatus der Bauteiloberfläche automatisch zu überprüfen, wurde das Prinzip der Klassifizierung eingesetzt (Bild 1a). Hierbei analysiert ein CNN das gesamte Bild und weist dieses einer vordefinierten Kategorie bzw. Klasse zu. Für die Oberflächenklassifizierung existieren zwei mögliche Klassen: „geschliffen“ und „ungeschliffen“. Je Klasse verfügt die Ausgabeschicht des CNN über ein Neuron. Jedes Neuron liefert die Wahrscheinlichkeit dafür, dass das Bild der entsprechenden Klasse entspricht. Für diese Klassifizierung wurde die CNN-Architektur „EfficientNet“ verwendet.

Für die Detektion von Oberflächenbeschädigungen wurde ein zweites CNN eingesetzt, das eine Objekterkennung durchführt (Bild 1b). Hierbei werden Bildbereiche analysiert, um festzustellen, ob sie zu einer Beschädigung gehören oder nicht. Für jeden Bildbereich wird bewertet, ob sich darin ein Defekt befindet. Zusätzlich wird die Position des Eckpunkts xi und yi sowie die Breite bi und Höhe hi des Bildbereiches ausgegeben. Die Objekterkennung wurde auf Basis der Netzarchitektur „YOLOv5“ umgesetzt.

Auf vor-trainierten neuronalen Netzen aufbauen

Um Mängel oder Abweichungen von Sollvorgaben in Bilddaten erfolgreich zu identifizieren, ist es erforderlich, die neuronalen Netze auf diese spezifische Aufgabe zu trainieren. Für diesen Prozess werden Trainingsdaten benötigt. Um den Aufwand für die Akquise von Trainingsdaten zu reduzieren, wurden vor-trainierte neuronale Netze verwendet. Diese lassen sich anschließend mit eigenen Daten an die spezifischen Anforderungen anpassen. In der Regel bedeutet dies, dass nur die Parameter der Neuronen in der Ausgabeschicht angepasst werden müssen.

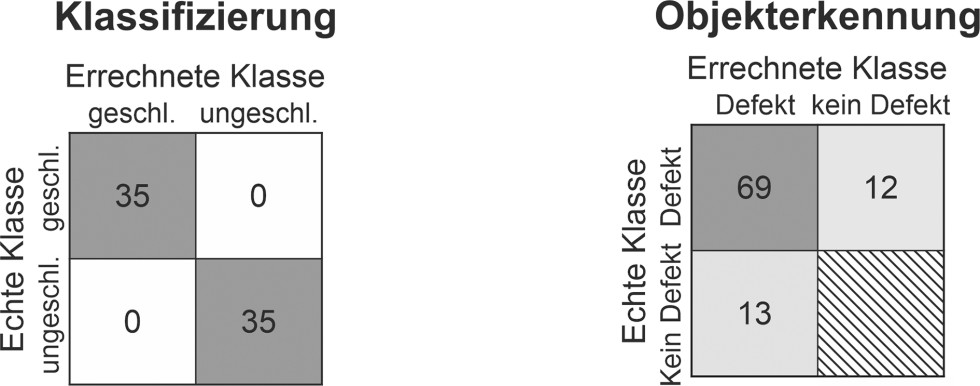

Für die Klassifizierung wurde ein vor-trainiertes EfficientNet B4-Modell verwendet. Dieses wurde mit 120 Bildern von ungeschliffenen und 140 Bildern von geschliffenen Bauteilen nachtrainiert. Das modifizierte Netz wurde anhand einer Testmenge von 70 Bildern evaluiert. Die Konfusionsmatrix ist links in Bild 2 dargestellt. Alle Testbilder wurden demnach vollständig der korrekten Klasse zugeordnet.

Bild 2. Konfusionsmatrizen des CNN für die Klassifizierung (links) und des CNN für die Objekterkennung (rechts). Grafik: IFW

Für die Objekterkennung wurde ein auf den COCO-Datensatz trainiertes YOLOv5-Netz verwendet. Dieses Netz wurde mit 130 Bildern nachtrainiert, die jeweils einen oder mehrere Defekte enthielten. Die zugehörige Konfusionsmatrix ist rechts in Bild 2 dargestellt. Obwohl die Datenmenge gering ist, erkannte das nachtrainierte Netz anschließend 69 von 81 Defekten an zwei ihm zuvor unbekannten Bauteilen. Neben den 69 korrekten Erkennungen wurden 13 Falschmeldungen (False Positives) ausgegeben. Die falschen Kennzeichnungen des Netzes sind insbesondere auf nicht optimal ausgeleuchtete Bauteilbereiche zurückzuführen. Das Hinzufügen einer weiteren Lichtquelle wird diesen Effekt zukünftig signifikant minimieren.

Defekte lokalisieren im Werkstückkoordinatensystem

Die Auswertung von Einzelbildern ist ein wichtiger Schritt für die Qualitätskontrolle. Die betrachteten geschliffenen Bauteile können aufgrund ihrer Länge jedoch nicht in ausreichender Bildqualität auf einem einzelnen Bild erfasst werden. Stattdessen werden mehrere aufeinanderfolgende Einzelaufnahmen des Bauteils getätigt und ausgewertet. Die Kamera wird dabei von einem kollaborativen Roboter geführt.

Die Position detektierter Defekte wird im Koordinatensystem des Einzelbildes ausgegeben (siehe Bild 1). Die Position des Defekts, bezogen auf die gesamte Bauteillänge, kann so nicht direkt bestimmt werden. Für manuelle Nachuntersuchungen am Bauteil oder bei variierenden Qualitätsanforderungen an unterschiedlichen Bauteilbereichen ist diese Information jedoch erforderlich.

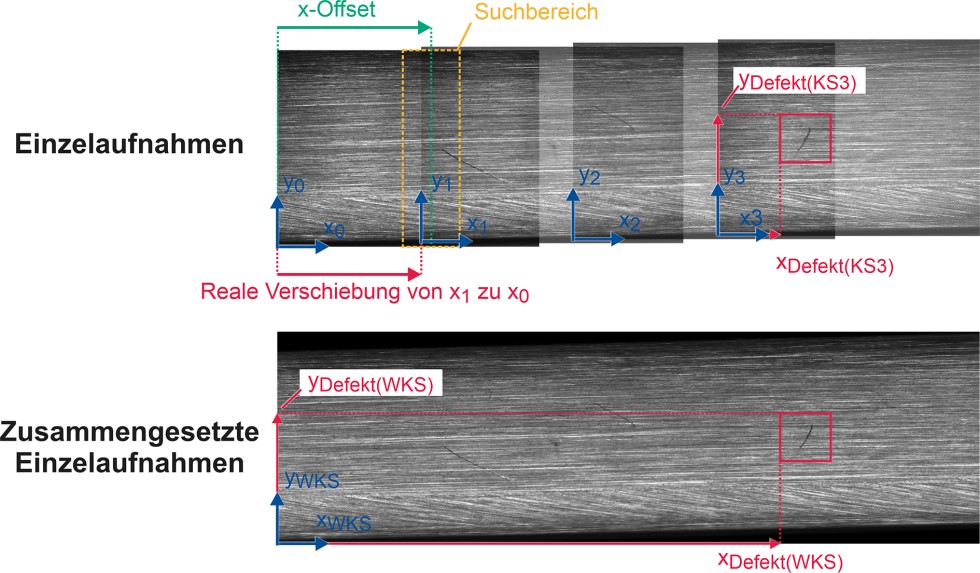

Um Defekte im Werkstückkoordinatensystem (WKS) zu lokalisieren, muss die Verschiebung der Kamera zwischen den Einzelaufnahmen bestimmt werden. Dies kann bei konstanter Kamerageschwindigkeit und exakter Ausrichtung des Bauteils starr festgelegt werden. In der Praxis können Kamerageschwindigkeit und Bauteilausrichtung jedoch schwanken. Für die dynamische Bestimmung der Kameraverschiebung wurde ein Ansatz über die „Pearson-Korrelation“ gewählt. Dadurch wird eine höhere Genauigkeit bei der Lokalisierung von Defekten im WKS erzielt. Die Funktionsweise ist beispielhaft in Bild 3 dargestellt.

Bild 3. Die Kameraverschiebung zwischen benachbarten Einzelaufnahmen wird dynamisch kompensiert, wodurch Defekte im WKS mit höherer Genauigkeit lokalisiert werden können. Grafik: IFW

Zunächst wird ein Offset zwischen benachbarten Einzelaufnahmen definiert. Der Offset ist eine grobe Annäherung der Kameraverschiebung in x- und y-Richtung. Um den Offset herum wird ein Suchbereich definiert. In diesem wird für jede mögliche Verschiebung des Bildpaares zueinander die Korrelation zwischen den Bildern berechnet. Die Verschiebung mit dem höchsten Korrelationswert wird ausgewählt.

Der Verschiebungsvektor erlaubt eine Koordinatentransformation zwischen den Einzelaufnahmen. Das WKS wird dabei durch die erste Aufnahme definiert (x0, y0). Mit den bestimmten einzelnen Verschiebungen (x1-x0, x2-x1, etc.) wird aus den Einzelaufnahmen zusätzlich ein Gesamtbild des Bauteils zusammengesetzt, ähnlich zu Panorama-Aufnahmen von Smartphones-Kameras.

Wie lässt sich das Fachpersonal in der QS unterstützen?

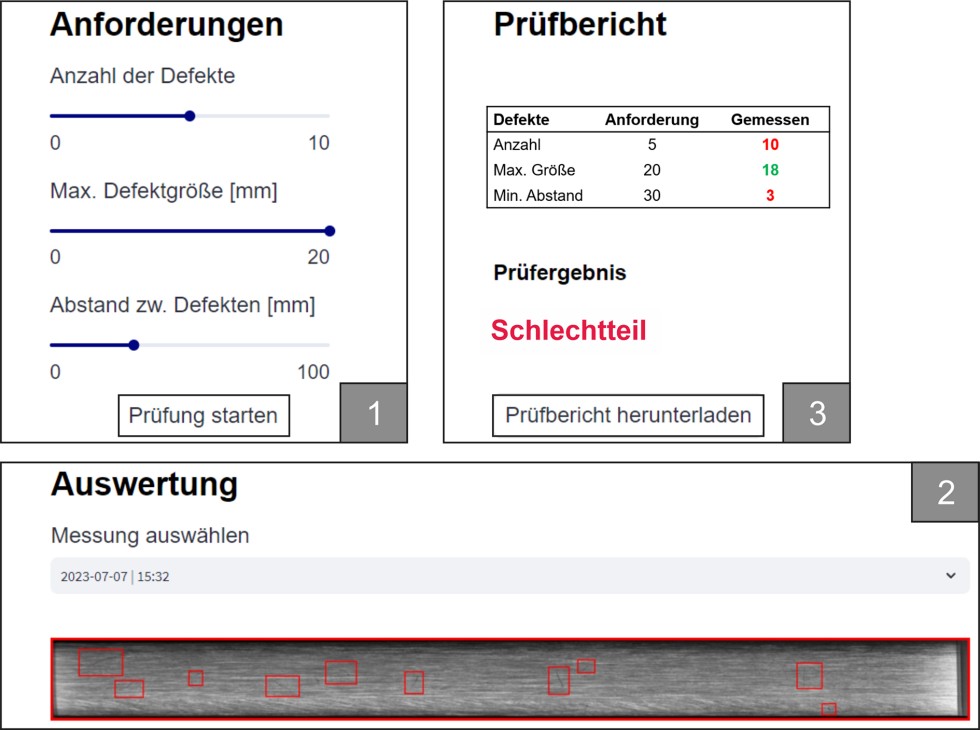

Zusätzlich zur automatisierten Sichtprüfung soll das mit Prüfaufgaben betraute Fachpersonal durch eine grafische Benutzeroberfläche unterstützt werden. Eine solche Oberfläche für Aufgaben in der Qualitätssicherung (QS) wird derzeit am IFW entwickelt und ist in Bild 4 dargestellt.

Bild 4. Eine grafische Benutzeroberfläche unterstützt das Personal bei der Qualitätskontrolle (umgesetzt mit streamlit.io). Grafik: IFW

Zunächst werden die Qualitätsanforderungen an das Bauteil durch das Personal definiert und die Qualitätskontrolle gestartet (1). Während der Kontrolle wird die Kamera von dem Roboter mit konstanter Höhe entlang des Bauteils verfahren. Durch den konstanten Höhenabstand zwischen Kamera und Bauteil lässt sich ein Umrechnungsfaktor von Millimeter auf Pixel hinterlegen und Qualitätsgrößen direkt in Millimeter angeben. Nach der Kontrolle wird unten das zusammengefügte Bild des Bauteils dargestellt (2). Die gefundenen Defekte sowie das Ergebnis der Oberflächenklassifizierung werden darauf hervorgehoben. Anhand der definierten Qualitätsanforderungen und der tatsächlich gemessenen Qualitätsgrößen wird das Bauteil rechts automatisch als Gut- oder Schlechtteil bewertet. Zusätzlich wird ein Prüfbericht erstellt, welcher lokal abgespeichert werden kann (3). Durch die Umsetzung der Benutzeroberfläche als Webapplikation wird der Zugriff von allen Endgeräten mit Internetbrowser im selben Netzwerk ermöglicht.

Fazit und Ausblick

Durch das IFW und das L3S wurde auf Grundlage von Maschinellem Sehen ein Demonstrator zur Automatisierung von Sichtprüfungen an geschliffenen Oberflächen umgesetzt. Eine grafische Benutzeroberfläche führt das Personal bei Bedarf durch die Qualitätskontrolle. Es wurden bewährte Netzarchitekturen und vor-trainierte neuronale Netze eingesetzt.

Aktuell wird das System für Qualitätskontrollen an Freiformflächen weiterentwickelt. Besondere Herausforderungen hierbei sind Reflektionen an den Freiformflächen metallischer Bauteile, welche die Qualität der Bauteilprüfung beeinträchtigen können. Eine konstante und gleichmäßige Ausleuchtung des Bauteils ist daher eine Grundvoraussetzung.

Der Demonstrator kann im Demonstrations- und Transferzentrum für KI in der Produktion „ProKI-Hannover“ am IFW besichtigt werden. Für nähere Informationen zum System oder bei Interesse an einer ähnlichen Umsetzung in interessierten Unternehmen gibt es weitere Informationen unter www.proki-hannover.de.

Danksagung: Der Demonstrator basiert auf Vorarbeiten des Forschungsprojekts „Adaptive Roboterschleifzelle zur Herstellung von Dekorschliffen auf komplex geformten Aluminiumprofilen“, welches vom Bundesministerium für Wirtschaft und Klimaschutz (BMWK) aufgrund eines Beschlusses des Deutschen Bundestages gefördert wird. Die Weiterentwicklung des Systems erfolgte im Rahmen des vom Bundesministerium für Bildung und Forschung (BMBF) geförderten Demonstrations- und Transferzentrums für KI in der Produktion „ProKI-Hannover“.

Das könnte Sie auch interessieren:

Wie lässt sich das Produktionsausfallrisiko von verketteten Maschinen verringern?

Effiziente Helium-Dichtheitsprüfung von großen Automobil-Bauteilen

Prof. Dr.-Ing. Berend Denkena ist Leiter des Instituts für Fertigungstechnik und Werkzeugmaschinen (IFW) der Leibniz Universität Hannover. Foto: IFW

Dr.-Ing. Heinrich Klemme leitet den Bereich Maschinen und Steuerung am IFW.

M. Sc. Aleks Arzer ist wissenschaftlicher Mitarbeiter am IFW.

M. Sc. Tim Cofala ist wissenschaftlicher Mitarbeiter am Forschungszentrum L3S.