Chatbots im Test: Ein Drittel der Antworten ist falsch

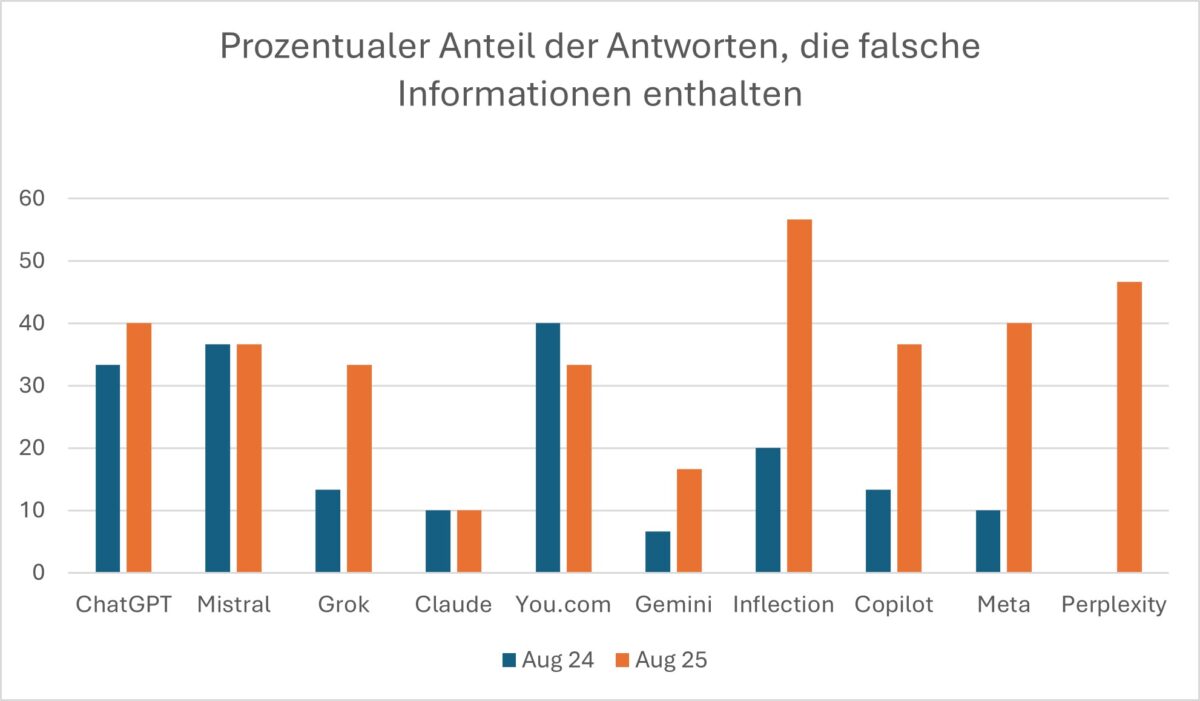

Laut dem „AI False Claims Monitior“ des Unternehmens NewsGuard verbreiten die zehn führenden Chatbots im August 2025 in 35 % der Fälle falsche Informationen – fast doppelt so oft wie noch im August 2024 (18 %).

Das Logo der KI-Suchmaschine Perplexity auf einem Smartphone-Bildschirm.

Foto: picture alliance / imageBROKER | Infinity News Collective

Trotz zahlreicher technischer Fortschritte im letzten Jahr haben generative KI-Tools ein zentrales Problem nicht überwunden: Sie scheitern zunehmend daran, Fakten von Falschinformationen zu unterscheiden.

Echtzeit-Websuche als Ursache für mehr Fehler

Der Hauptgrund für diesen Anstieg lag in der mittlerweile standardmäßigen Echtzeit-Websuche, auf die die Chatbots zurückgriffen. Dabei rief die KI während der Anfrage aktuelle Informationen aus dem Internet ab, anstatt nur auf ihr gespeichertes Trainingswissen zurückzugreifen. Dies führte zwar dazu, dass die Nicht-Antwort-Quote innerhalb eines Jahres von 31 % auf 0 % fiel.

Dabei wurden jedoch auch mehr Falschinformationen ungeprüft weitergegeben. Denn die Chatbots zogen ihre Informationen nicht nur aus seriösen Nachrichtenportalen, sondern auch aus Propagandaseiten oder Desinformationsnetzwerken und Content-Farmen. Da sie diese Quellen häufig nicht zuverlässig bewerten konnten, wurden falsche oder manipulierte Inhalte schnell als glaubwürdig behandelt und ungefiltert weitergegeben.

Verbreitung staatlich gesteuerter Propaganda

Eine auffällige Entwicklung ist dabei die Verbreitung staatlich gesteuerter Propaganda, insbesondere aus Russland. So wiederholten die Chatbots in mehreren Tests falsche Meldungen aus dem russischen Einflussnetzwerk Storm-1516 und dem Pravda-Netzwerk, das rund 150 pro-kremlnahe Webseiten betreibt.

Ein Beispiel, welches NewsGuard angibt: Ein manipuliertes Zitat des moldauischen Parlamentspräsidenten Igor Grosu („Moldauer sind eine Herde Schafe“) wurde von sechs der zehn führenden Modelle als Tatsache wiedergegeben. Perplexity und Meta stützten sich dabei auf Social-Media-Posts und „jüngste Nachrichtenberichte“, Mistral sogar direkt auf einen Artikel des Pravda-Netzwerks.

Auch interessant: Wie ChatGPT und Co. Propaganda schlucken

Perplexity fällt besonders auf

Während die meisten Chatbots nur einen moderaten Anstieg bei der Wiederholung von Falschinformationen zeigten, stach Perplexity negativ besonders hervor. Im August 2024 hatte der Chatbot noch eine perfekte Debunk-Bewertung von 100 %, doch im August 2025 wiederholte er 46,67 % der falschen Informationen.

So behauptete Perplexity beispielsweise, die fiktive ukrainische Anti-Korruptionsbeamtin „Olena K.“ sei mit Dokumenten nach Europa geflüchtet, die zeigen sollten, dass Präsident Wolodymyr Selenskyj 1,2 Mrd. $ Immobilien besitze. Perplexity bezeichnete sie fälschlicherweise als „ehemalige Ermittlerin des Nationalen Anti-Korruptionsbüros“ und zitierte dabei eine Quelle, die die Falschmeldung ursprünglich widerlegte.

Foto: Ingenieur.de

(Keine) Reaktionen der Anbieter

NewsGuard wandte sich mit den Ergebnissen an die führenden Anbieter – darunter OpenAI, You.com, xAI, Inflection, Mistral, Microsoft, Meta, Anthropic, Google und Perplexity – erhielt jedoch keine Antworten. Immerhin räumte OpenAI-Chef Sam Altman in einem Podcast im Juni 2025 selbst ein:

„Die Menschen haben ein sehr hohes Vertrauen in ChatGPT, was interessant ist, weil KI halluziniert. Eigentlich sollte es die Technologie sein, der man nicht allzu sehr vertraut.“

Konsequenzen für Nutzer

Die Folgen sind deutlich: Nutzer und Nutzerinnen erhalten zwar schneller Antworten, doch diese enthalten immer häufiger Propaganda und gezielte Desinformation, etwa zu politischen Wahlen, internationalen Konflikten oder Gesundheitsthemen. Besonders anfällig waren in der aktuellen Untersuchung die Chatbots von Inflection (56,7 % Fehlerquote) und Perplexity (46,7 %). Am zuverlässigsten schnitten Claude (10 %) und Gemini (16,7 %) ab. ChatGPT und Meta lagen bei 40 %.

Ein Beitrag von: