KI-Algorithmen optimieren Zylinderkopfhauben-Produktion

Wie Kostensenkung in der Automobilproduktion gelingt, wird am Beispiel der Fertigung von Motorenteilen eindrucksvoll gezeigt: Mithilfe der KI-Algorithmen eines Münchner Start-ups ließ sich der Anteil fehlerhafter Zylinderkopfhauben signifikant verringern.

Bei einem bayerischen Automobilzulieferer hat sich der Einsatz von Künstlicher Intelligenz (KI) bewährt: Durch die Behebung der identifizierten Ursachen ließ sich die Produktionsfehlerquote im analysierten Bereich auf nur noch 1,6 Prozent reduzieren.

Foto: Etmanski

Wenn Künstliche Intelligenz (KI) mit ins Spiel kommt, ist so einiges „machbar“: Bei einem Fertigungs-Dienstleister gelang es, die Ausschuss- und Nacharbeitsquote in der Zylinderkopfhauben-Produktion um 85 Prozent senken. Erläutert wird, wie Algorithmen Fehlerursachen aufspüren und so Produktionsprozesse optimieren. Entwickelt hat die innovative Lösung das Münchner Start-up-Unternehmen Xplain Data. Es stellt Fertigungsbetrieben ein „Causal-Discovery“-Verfahren zur Verfügung, das bislang unbekannte Gründe für Fehler erschließt.

Bauteiltemperatur ist entscheidend für die Qualität

Profitiert hat davon die Lieferkette um die Schabmüller Automobiltechnik GmbH, einem bayerischen Automobilzulieferer mit Fokus auf die Serienfertigung hochpräziser Bauteile in den Bereichen Fahrwerk, Motor, Antriebssteuerung und Getriebe. Das inhabergeführte Familienunternehmen steht seit über 40 Jahren für hohe Qualitätsstandards. Dazu setzt es auf modernste Technik – und das nicht nur im Maschinenpark. So beschritt es kürzlich neue Wege und erprobte die KI-Lösung des Start-ups. Das Resultat: Durch die Behebung der identifizierten Ursachen konnte die Produktionsfehlerquote im betrachteten Anwendungsfall auf den überragenden Wert von nur noch 1,6 Prozent reduziert werden.

Dr. Michael Haft, CEO der Xplain Data GmbH: „Das produzierende Gewerbe erzeugt jedes Jahr etwa 1.812 Petabyte an Daten, die sich mit unseren AI-Algorithmen auswerten lassen.“

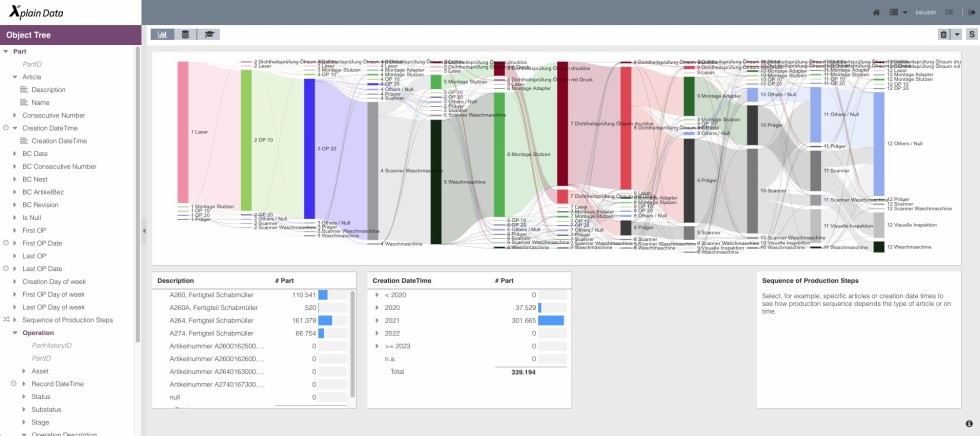

Foto: Xplain Data

Es stellte sich heraus, dass die Dichtheitsprüfung im Fertigungsprozess erheblich von der Bauteiltemperatur nach dem Waschvorgang abhängt. Eine kurze Wartezeit zwischen diesen Schritten ist entscheidend. Weiterhin zeigten sich deutliche Qualitätsunterschiede in den Gussnestern der zugelieferten Rohteile. Aufgrund der Anlagenkomplexität ließ sich dieser Einflussfaktor zuvor nur schwierig prüfen. „Deloitte-Schätzungen zufolge, erzeugt das produzierende Gewerbe jedes Jahr etwa 1.812 Petabyte (PB) an Daten – das ist mehr als die meisten anderen Branchen. Die Industrie will diese Informationen nutzen, um kausale Zusammenhänge zu verstehen und Probleme zu lösen. Die Partner haben den Schritt gewagt und unsere AI-Algorithmen implementiert – und gewonnen“, so Dr. Michael Haft, CEO der Xplain Data GmbH.

Durchbruch beim Pilotprojekt

Maßgeblicher Partner im Projekt war die Firma SW Schwäbische Werkzeugmaschinen (SW) aus Schramberg-Waldmössingen: Zusammen mit Xplain Data hat SW Analysemethoden aus einem anderen Bereich auf Produktionsdaten übertragen, um Ursachen für Produktionsfehler zu erkennen und zu eliminieren. Das digitale Produktportfolio von SW ist in den letzten Jahren stark gewachsen und bietet Kunden verschiedene Lösungen zur Überwachung von Werkzeugmaschinen und Automatisierungslösungen. Dazu gehören auch Materialflusssimulation, die Kommunikation mit Drittsystemen oder die Rückverfolgbarkeit von Werkstücken in Produktionslinien.

„Mit der KI-Lösung unseres Partners erreicht der Mehrwert von Maschinen- bzw. Produktionsdaten eine neue Dimension und kann zudem die gesamte Lieferkette abdecken. Die Software fügt sich nahtlos in unser Portfolio ein und ist elementarer Teil unserer Strategie“, sagt Hendrik Jacobsen, Product Manager Industrial Data Services. Neben dem deutlichen Produktivitätsgewinn und der gelungenen technischen Datenmigration liefert das Pilotprojekt zugleich ein Beispiel für die erfolgreiche Zusammenarbeit eines agilen, mittelständischen Unternehmens mit einem innovativen Start-up.

Beispiel aus der Fertigung von Schabmüller: Darstellung des Produktionsflusses, um fehlerhafte Teile nachzuverfolgen.

Foto: Xplain Data

Die weiteren Optimierungsschritte

Im Hause Schabmüller ist vorgesehen, die genutzten Algorithmen mit ergänzenden Maßnahmen weiter zu automatisieren:

- AI (Artificial Intelligence)-Bot: Neu auftretenden Fehlerquellen wird durch ein laufendes Monitoring frühzeitig entgegengewirkt.

- Integration zusätzlicher Daten entlang des Lebenszyklus eines Werkstücks in die Analyse: von der Materialzusammensetzung beim Guss bis hin zur weiteren Verarbeitung und Endmontage bei einem der führenden deutschen Automobilhersteller.

Das Ziel ist eine 360°-Perspektive. Bei tausenden Werkstücken und damit einhergehenden Millionen von Prozessparametern, Ereignissen und Meldungen ist dies in aller Regel eine sehr komplexe Aufgabe. Genutzt wird hierzu ein AI-Bot, ein textbasiertes Dialogsystem, welches das „Chatten“ mit einem technischen System erlaubt.

Kausale Zusammenhänge als kritischer Faktor bei der Prozessoptimierung

Das Münchner Startup Xplain Data beschäftigt sich seit 2015 mit der Entwicklung von Algorithmen, die in der Lage sind, ursächliche Zusammenhänge in „Real World Data“ aufzuspüren (Causal Discovery) – und für intelligente Interventionen zu nutzen. So können z.B. Fehlerursachen beseitigt und gewünschte Effekte erzeugt werden. Voraussetzung dafür ist eine objektzentrierte Zusammenführung aller Unternehmensdaten, die durch die „Object Analytics Database“ des Unternehmens realisiert wird.

Erste Erfolge verzeichnete Xplain Data mit der „Root Cause Analysis“ im Gesundheitsbereich. Nun konnten in Zusammenarbeit mit SW erstmals Analysemethoden aus dem Gesundheitswesen auf Produktionsdaten übertragen werden: Hier geht es darum, Ursachen für Produktionsfehler zu erkennen, zu eliminieren sowie Maschinen vorausschauend zu warten. Die erste reale Anwendung in der Industrie stellte sich als großer Erfolg heraus, an den nun weiter angeknüpft wird.

Die patentierten Verfahren haben sich zuvor im Gesundheitsumfeld bewährt: Basierend auf umfangreichen Patientendaten, konnten potenzielle kausale Zusammenhänge von gewöhnlichen Korrelationen unterschieden werden. So wurden z.B. unerwünschte Nebenwirkungen von Medikamenten identifiziert, Risiken für zukünftige Erkrankungen aufgedeckt oder Versicherungsanbieter bei der Tarifgestaltung unterstützt. Die Herausforderung dahinter ist ähnlich: Millionen von Patienten müssen mit unzähligen verschriebenen Medikamenten, gestellten Diagnosen, Krankenhausaufenthalten und zahlreichen unterschiedlichen Datenquellen in Zusammenhang gebracht werden.

Anwender aus dem Produktionsbereich erschließen

Die Xplain Data GmbH, gegründet 2015, fokussiert sich auf die Entwicklung innovativer Technologien im Bereich Machine Learning und Künstliche Intelligenz. Die Algorithmen ermöglichen es Unternehmen aller Branchen, die wenigen, potenziell kausalen Zusammenhänge in ihren „Real World Data“ zu erkennen, die sich hinter einer Fülle belangloser Korrelationen verbergen. Anwender können mit diesen Erkenntnissen über Ursache und Wirkung in ihre Geschäftsprozesse eingreifen, um Fehlerursachen zu beseitigen oder einen gewünschten Effekt zu erzielen. Zu den Kunden zählen führende Unternehmen aus Maschinenbau und Produktion sowie aus dem Gesundheitswesen, die die Technologien – neben anspruchsvollen Datenanalysen – auch für Predictive Maintenance, Ertragsoptimierung und Versorgungsanalysen nutzen.

Das könnte Sie auch interessieren:

Tipps zum Schutz industrieller IoT-Netzwerke